Jak już powszechnie wiadomo, Microsoft sam buduje optykę dla HoloLens 2.0. Bodaj najciekawszym jej składnikiem jest moduł optyczny Project Kinect for Azure - ten sam, który Satya Nadella przedstawiał parę miesięcy temu na konferencji Build w kontekście rozwiązań IoT/AI. Technologia, wyposażona w ultraszeroki kąt widzenia, odpowiadać będzie za wysokiej klasy rozpoznawanie przestrzenne, rozpoznawanie obiektów i śledzenie ruchów szkieletowych. To wiedzieliśmy głównie z teorii. Teraz dane nam jest zobaczyć działanie sensora w czasie rzeczywistym!

Krótko po majowej konferencji Alex Kipman wyjawił, że sensor, który Satya opisał na scenie konferencji Build, jest także sensorem, który da nowej wersji HoloLens nowe możliwości. Microsoft postanowił więc wykorzystać tę technologię dwojako - umieścić we własnym urządzeniu i wypuścić jako moduł do budowy praktycznie dowolnych rozwiązań zewnętrznych. Dziś zobaczymy, jak ów czujnik głębi działa. Udostępniając wczoraj film demonstracyjny, Microsoft Research napisał:

Prezentujemy prototyp technologii czujnika głębi time-of-flight, który zostanie zaadaptowany w Project Kinect for Azure, jak również w następnej generacji HoloLens. Ten czujnik głębi pozostawia w tyle obecny stan techniki pod względem precyzji [pomiaru] głębi, utrzymując przy tym zarówno niewielkie rozmiary, jak i wysoką efektywność energetyczną. Czujnik głębi wspiera różne zakresy głębi, częstotliwości wyświetlania klatek i rozdzielczości obrazu. Użytkownik może wybierać między trybami dalekiego i średniego pola widzenia. Nasza technologia głębi używana jest w scenariuszach interakcji w czasie rzeczywistym, takich jak śledzenie dłoni lub szkieletu, i umożliwia wysokiej rozdzielczości mapowanie przestrzenne. Wspomaga ona również badaczy i deweloperów w budowaniu nowych scenariuszy dla pracy z inteligencją przestrzenną z użyciem Azure AI.

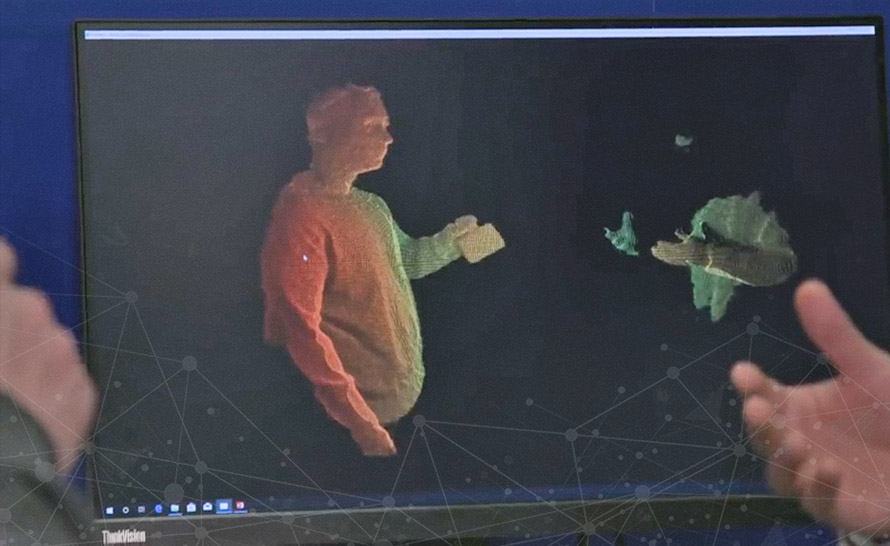

Zobaczmy zatem, jak w czasie rzeczywistym czujnik Project Kinect for Azure śledzi ruchy (a w zasadzie rejestruje w trójwymiarze całe dostępne w jego polu modele) ludzi:

Już na pierwszy rzut oka widać, że chmura punktów, które tworzą siatkę modelu 3D, prezentuje się znacznie dokładniej i stabilniej, niż w przypadku obecnej, pierwszej generacji HoloLens, która używa czujnika głębi Kinect trzeciej generacji. Technologia ta przy niewielkim poborze mocy zapewnia wysoką rozdzielczość (1024x1024) i dobrze radzi sobie z rozróżnianiem obiektów oddalonych w różnym stopniu od sensora.

Pozostaje oczywiście pytanie, kiedy ta technologia opuści laboratoria Microsoftu i wyjdzie do ludzi (nowy HoloLens ma być urządzeniem nastawionym na konsumenta). Microsoft na ten temat nadal milczy, ale najczęściej powtarzana nieoficjalna wersja mówi o pierwszym kwartale 2019 roku.

341f31d.png)