W zeszłym roku Microsoft pokazał kilka przykładów usług transkrypcji mowy, np. podczas konferencji, i ekstrakcji metadanych z wideo z użyciem AI. W obu tych przypadkach sztuczna inteligencja rozpoznaje mówców po głosie i potrafi przypisać im wypowiadane przez nich zdania, które następnie umieszcza na osi czasu nagrania, pozwala przeszukiwać etc. W tym roku gigant zaprezentował kolejne osiągnięcia na tym polu. Przede wszystkim, by ogarniać mówców, AI działająca w Azure nie potrzebuje już dedykowanego sprzętu i wystarczą jej nawet zwykłe mikrofony, np. wbudowane w telefon. Lepiej poradzi sobie również z niestandardowym słownictwem.

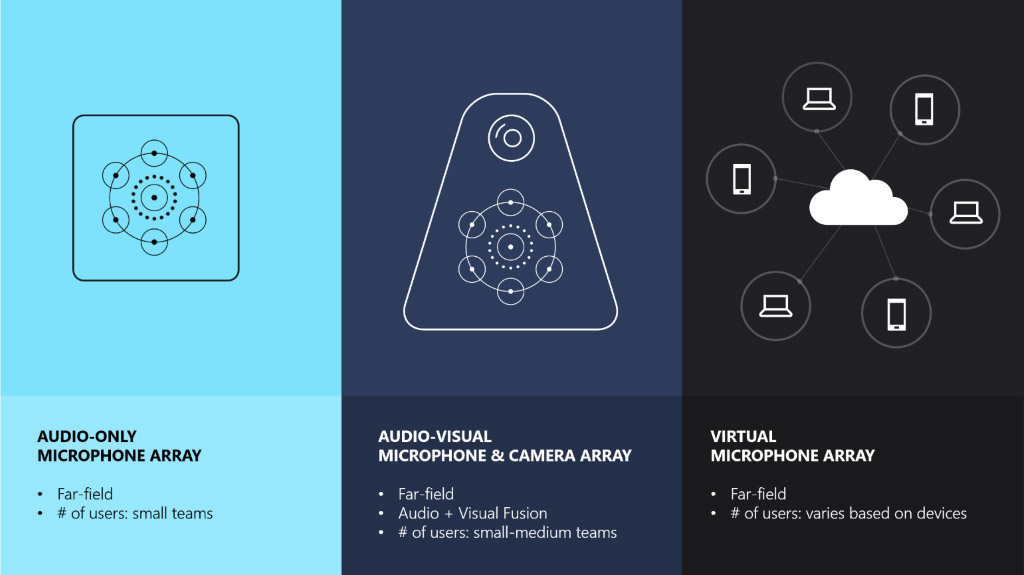

Jedna z demonstracji na minionym Build 2019 poświęcona była zagadnieniu smart-meetings, czyli spotkań wspomaganych sztuczną inteligencją. Gigant zaprezentował nową funkcję transkrypcji konwersacji, która wchodzi w skład Azure Speech Service. Funkcja, dostępna już w wersji zapoznawczej, pozwala na transkrypcję rozmów z wieloma użytkownikami w czasie rzeczywistym - nawet jeśli jednocześnie mówi więcej osób. Nazywane jest to "automatyczną atrybucją mówiących". Oprócz tego Microsoft pokazał jeszcze działanie usługi nie tylko na własnym sprzęcie referencyjnym - tak jak na Build zeszłym roku - ale również z udziałem wirtualnego zestawu mikrofonów.

Jak pewnie nasi Czytelnicy pamiętają, Microsoft od pewnego czasu intensywnie badał kształtowanie dźwięku w pomieszczeniach i działał nie tylko na warstwie sprzętowej, ale tworzył na tej podstawie różne wirtualne symulacje. Na demonstracji użyta została właśnie owa część wirtualna, oparta na chmurze. Konkretnie jest projekt Microsoft Research o nazwie Project Denmark. Zamiast polegać na dedykowanych układach mikrofonowych, Project Denmark pozwala użytkownikom skonfigurować "wirtualne" układy wykorzystujące urządzenia konsumenckie, takie jak telefony i laptopy ze zwykłymi mikrofonami. Pozwoli to użytkownikom brać udział w smart-meetings niezależnie od tego, gdzie są.

Wróćmy jeszcze do kwestii rozpoznawania mowy. Jak można się łatwo przekonać, ogólnodostępne systemy zamiany mowy na tekst radzą sobie najlepiej z popularnym słownictwem, a słowa żargonowe albo skrótowce niezdarnie zamieniają na brzmiące podobnie, powszechne wyrażenia. Aby rozwiązać ten problem (np. podczas konferencji technicznych), Azure pozwala teraz firmom wgrać własne modele mowy z użyciem danych Office 365. Innymi słowy można dodać własny słownik, by system rozpoznawania mowy w Azure wiedział, jakie niestandardowe słownictwo powinien wyłapywać.

341f31d.png)