Microsoft i NVIDIA rozszerzają swoją wieloletnią współpracę, dodając nowe integracje, które wykorzystują najnowsze technologie generatywnej sztucznej inteligencji i Omniverse™ firmy NVIDIA w Microsoft Azure, usługach Azure AI, Microsoft Fabric i Microsoft 365. W znaczący sposób rozwinie to infrastrukturę AI i umożliwi realizowanie wielu przełomowych scenariuszy.

Rozwój infrastruktury AI

Microsoft będzie jedną z pierwszych organizacji, które wykorzystają moc NVIDIA Grace Blackwell GB200 oraz NVIDIA Quantum-X800 InfiniBand w Azure, dostarczając najnowocześniejsze, liczące bilion parametrów modele przetwarzania języka naturalnego, rozpoznawania obrazów (computer vision), rozpoznawania mowy i nie tylko.

Gigant ogłosił także ogólną dostępność maszyny wirtualnej Azure NC H100 v5 VM opartej na NVIDIA H100 NVL. Seria maszyn wirtualnych NC jest zaprojektowana do trenowania i wnioskowania średniego kalibru, oferując klientom dwie klasy VM z 1-2 NVIDIA H100 94GB PCIe Tensor Core GPUs i obsługą technologii NVIDIA Multi-Instance GPU (MIG), która pozwala partycjonować każdy GPU do 2-7 instancji, co zapewnia elastyczność i skalowalność dla różnorodnych obciążeń AI.

Przełomy w opiece zdrowotnej i naukach biologicznych

Microsoft rozwija współpracę z NVIDIĄ, aby przetransformować opiekę zdrowotną i nauki o życiu poprzez integrację technologii chmury, AI i superkomputerów. Wykorzystując moc Microsoft Azure wraz z NVIDIA DGX™ Cloud i zestawem mikroserwisów NVIDIA Clara™, podmioty lecznicze, firmy farmaceutyczne i biotechnologiczne oraz deweloperzy urządzeń medycznych będą mogli wkrótce wprowadzać błyskawiczne innowacje w badaniach klinicznych i świadczeniu opieki z większą wydajnością.

Liderzy branżowi, tacy jak Sanofi oraz Broad Institute of MIT and Harvard, ISVs, tacy jak Flywheel i SOPHiA GENETICS, akademickie centra medyczne, takie jak University of Wisconsin School of Medicine and Public Health, oraz systemy opieki zdrowotnej, takie jak Mass General Brigham, już teraz wykorzystują chmurę obliczeniową i AI, aby napędzać transformatywne zmiany w opiece zdrowotnej i rozwijać opiekę nad pacjentami.

Cyfryzacja przemysłowa

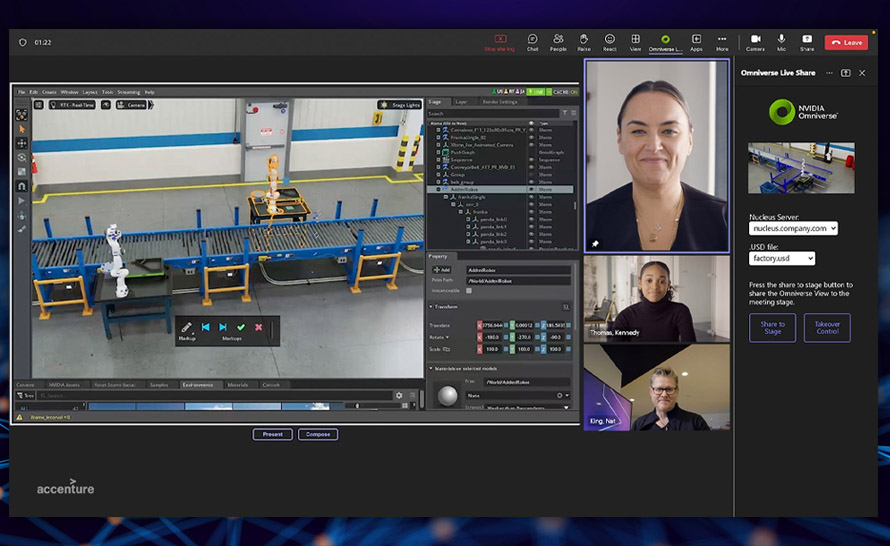

NVIDIA Omniverse Cloud APIs będą dostępne najpierw w Microsoft Azure jeszcze w tym roku. Umożliwi to deweloperom lepszą współpracę w zakresie interoperacyjności danych oraz wizualizację opartą na fizyce w istniejących aplikacjach. Na wydarzeniu NVIDIA GTC Microsoft zaprezentował przykładowe możliwości wykorzystania APIs Omniverse Cloud na platformie Azure. Korzystając z interaktywnej przeglądarki 3D w Microsoft Power BI, operatorzy fabryk mogą wyświetlać dane w czasie rzeczywistym nałożone na cyfrowego bliźniaka 3D swojego zakładu, aby uzyskiwać nowe wglądy, które mogą przyspieszyć produkcję.

NVIDIA Triton Inference Server oraz Microsoft Copilot

Procesory graficzne NVIDIA oraz NVIDIA Triton Inference Server™ pomagają w przewidywaniu wnioskowania AI w usłudze Copilot dla Microsoft 365. Copilot otrzyma wkrótce dedykowany przycisk klawiatury fizycznej na PC z Windows 11. Usługa łączy moc dużych modeli językowych z indywidualnymi danymi firm, dostarczając skontekstualizowaną sztuczną inteligencję w czasie rzeczywistym, wspomagając kreatywność, produktywność i umiejętności użytkowników.

Od trenowania do wdrażania AI

Mikroserwisy wnioskowania VIDIA NIM™ zmierzają do Azure AI, aby turbodoładować wdrożenia AI. Będący częścią platformy oprogramowania NVIDIA AI Enterprise i dostępny też w Azure Marketplace, NIM oferuje natywne dla chmury mikroserwisy do optymalizowania wnioskowania na ponad 20 popularnych modelach podstawowych, w tym na modelach zbudowanych przez NVIDIA, które można sprawdzić na stronie ai.nvidia.com.

Na potrzeby wdrożenia mikroserwisy udostępniają wstępnie zbudowane, działające w dowolnym miejscu kontenery obsługiwane przez oprogramowanie wnioskowania NVIDIA AI Enterprise — w tym Triton Inference Server, TensorRT™ i TensorRT-LLM — aby pomóc deweloperom skrócić czas wprowadzania na rynek zoptymalizowanych pod kątem wydajności produkcyjnych aplikacji AI.