Microsoft zaktualizował portal Azure AI Foundry oraz interfejsy API i zestawy SDK Azure OpenAI Service, aby dodać obsługę Direct Preference Optimization (DPO) for GPT-4.1 i GPT-4.1-mini. Ta metoda optymalizacji jest techniką fine-tuningu, która może okazać się przydatna, aby dostosować wagę modelu na podstawie preferencji człowieka. To wyjątkowo ciekawa i przyjazna technika.

GPT-4.1 i GPT-4.1-mini obsługują teraz metodę Direct Preference Optimization (DPO). Pozwala ona dostroić wagę modelu w oparciu o preferencje użytkownika. Jak to działa? Ty dostarczasz prompt wraz z dwiema odpowiedziami: preferowany i niepreferowany przykład. Używając tych danych, możesz dopasować fine-tuningowany model do własnego stylu, preferencji lub wymagań bezpieczeństwa – wyjaśnia Alicia Frame, PPM z działu Azure OpenAI w Microsoft.

"Bezpośrednia optymalizacja preferencji" może okazać się świetną techniką fine-tuningu dużych modeli językowych (LLMs) w scenariuszach, gdy nie ma jednej poprawnej odpowiedzi, a istotne są elementy subiektywne, takie jak ton, styl albo konkretne treści. Dzięki temu model AI może uczyć się w oparciu o pozytywne przykłady (uważane przez użytkownika za poprane lub idealne) oraz przykłady negatywne (najmniej pożądane lub niepoprawne).

DPO jest uważany za technikę, która ułatwi klientom generowanie wysokiej jakości zestawów danych treningowych. Podczas gdy wielu klientów zmaga się z generowaniem dostatecznie dużych zestawów danych do nadzorowanego dostrajania [supervised fine-tuning], zwykle mają już zebrane dane o preferencjach w oparciu o logi użytkowników, testy A/B albo mniejsze starania z ręcznymi adnotacjami.

— Microsoft Learn

Dowiedz się więcej:

- Czym są AI Driven Applications?

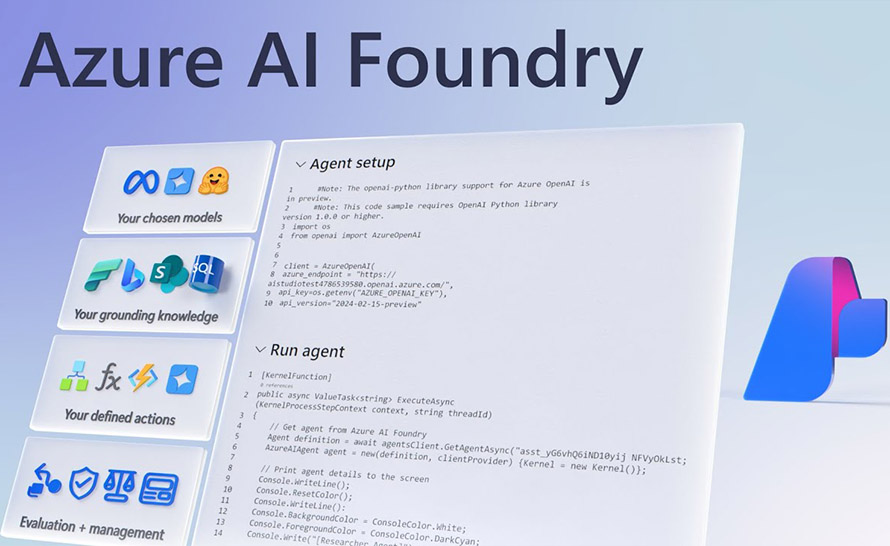

- Nowe możliwości dostrajania modeli w Azure AI Foundry

- Nadchodzi duża zmiana platformowa AI. Microsoft utworzył nowy dział

- OpenAI wypuścił GPT-4.1 - najmądrzejszy model AI do złożonych zadań

- GPT-4 dostępny w Azure OpenAI Service

- Grok 3, Sora i wiele innych nowości w Azure AI Foundry