OpenAI wypuściło wczoraj o3-mini. To najnowsza wersja przystępnego modelu sztucznej inteligencji, który dorównuje wydajnością modelowi OpenAI o1 w matematyce, kodowaniu i naukach ścisłych (STEM) z zachowaniem niskiego kosztu i zmniejszonej latencji o1-mini. Od pierwszego dnia model jest dostępny w ChatGPT (płatne subskrypcje), poprzez API, a także w Microsoft Copilot Chat, GitHub Copilot i GitHub Models. Sprawdźmy szczegóły.

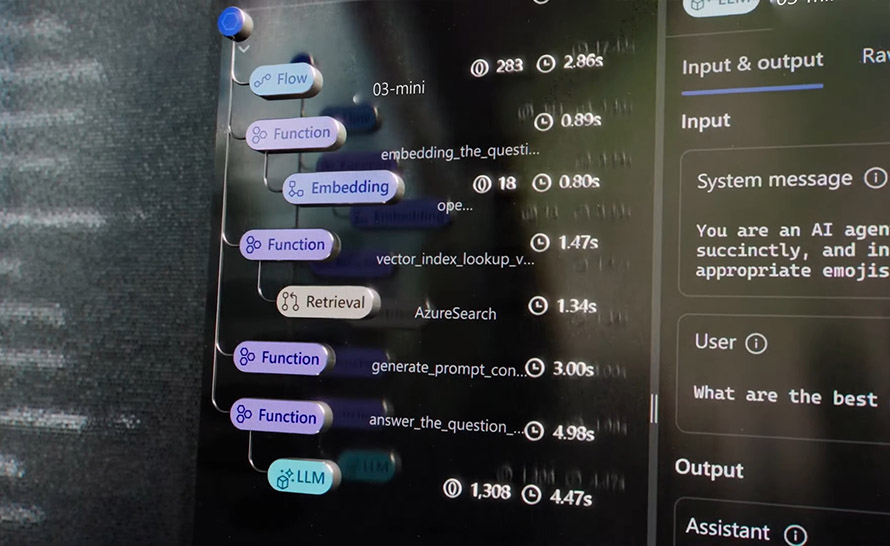

OpenAI o3-mini to pierwszy model wnioskowania firmy, który obsługuje wyczekiwane przez deweloperów funkcje, takie jak wywoływanie funkcji, Structured Outputs i wiadomości dewelopera. Podobnie jak o1-mini i o1-preview, o3-mini będzie obsługiwał streaming. Deweloperzy mogą wybierać pomiędzy 3 opcjami wnioskowania – niską, średnią i wysoką – aby zoptymalizować model dla różnych przypadków użycia. Ta elastyczność pozwala o3-mini "myśleć ciężej" przy złożonych wyzwaniach albo priorytetyzować szybkość, gdy latencja stanowi problem. Wydawca zaznacza, że o3-mini nie ma umiejętności przetwarzania obrazów (computer vision), dlatego do tych zadań deweloperzy powinni wykorzystywać raczej o1.

Nowy model jest również dostępny w produktach Microsoftu. Jak czytamy na blogu AI + machine learning:

Z przyjemnością ogłaszamy, że OpenAI o3-mini jest teraz dostępny w Microsoft Azure OpenAI Service. o3-mini dodaje znaczące oszczędności kosztów w porównaniu z o1-mini wraz z rozwiniętym wnioskowaniem, nowymi funkcjami takimi jak kontrola wysiłku wnioskowania oraz narzędziami, zapewniając przy tym porównywalną lub lepszą responsywność.

Zaawansowane możliwości o3-mini w połączeniu z jego wzrostami wydajności sprawiają, że jest to potężne narzędzie dla deweloperów i przedsiębiorstw, które chcą zoptymalizować swoje aplikacje AI.

Dzięki szybszemu działaniu i niższej latencji o3-mini jest zaprojektowany, aby sprostać złożonym obciążeniom wnioskowania przy zachowaniu wydajności.

— Yina Arenas, Vice President of Product, Core AI, Microsoft