Microsoft uniezależnia się od zewnętrznych dostawców sprzętu dla sztucznej inteligencji. Gigant zaprezentował Maia 200 – autorski akcelerator inferencyjny nowej generacji, zaprojektowany od podstaw z myślą o radykalnej poprawie efektywności ekonomicznej procesów generowania tokenów AI. To potężne narzędzie, które według zapowiedzi producenta staje się obecnie najwydajniejszym autorskim procesorem dostępnym wśród dostawców usług chmurowych, wyprzedzając pod względem czystej mocy obliczeniowej rozwiązania Amazona czy Google.

Wyprodukowany w najnowocześniejszym, 3-nanometrowym procesie TSMC, każdy chip Maia 200 zawiera ponad 140 mld tranzystorów i jest dostosowany do obciążeń AI w dużej skali, zapewniając przy tym efektywny współczynnik wydajności na dolara. W obu aspektach Maia 200 została zbudowana, by osiągać doskonałość. Została ona zaprojektowana dla najnowszych modeli używających obliczeń niskiej precyzji, a każdy chip Maia 200 dostarcza ponad 10 petaFLOPS w 4-bitowej precyzji (FP4) oraz ponad 5 petaFLOPS przy precyzji 8-bitowej (FP8), a wszystko to w obudowie SoC o TDP 750 W. W praktyce Maia 200 bez problemu obsługuje największe współczesne modele, oferując jednocześnie duży zapas mocy dla jeszcze większych modeli w przyszłości.

— Scott Guthrie, EVP działu Cloud + AI w Microsoft

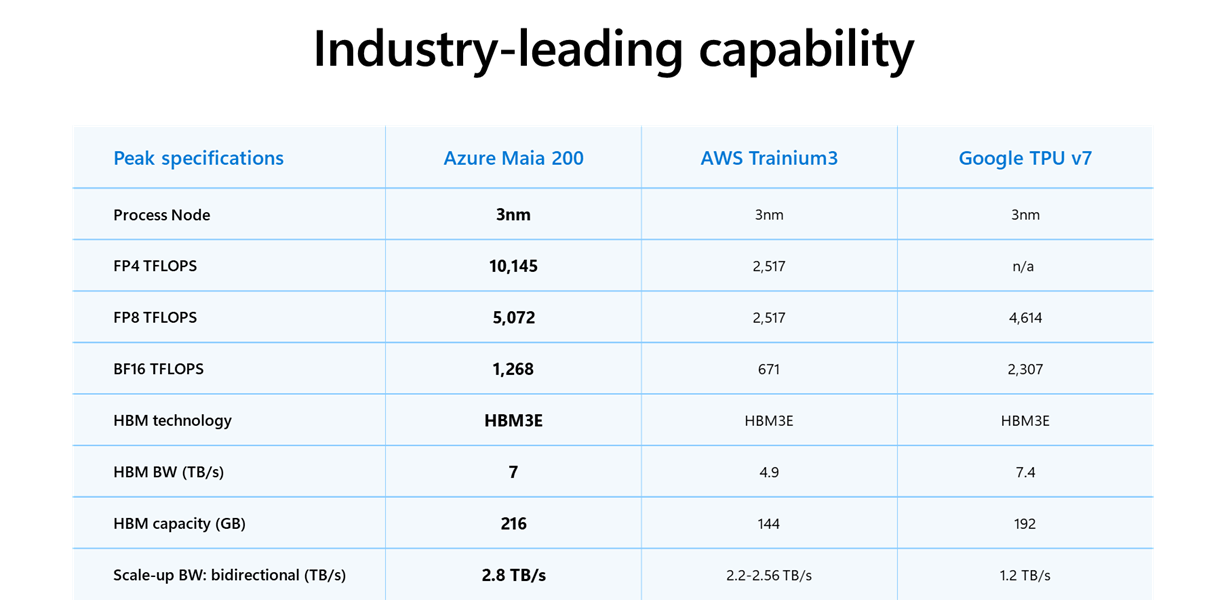

Parametry układu Maia 200 sprawiają, że przewyższa on 3-krotnie wydajność FP4 trzeciej generacji układów Amazon Trainium i osiąga wyniki w formacie FP8 wyższe niż siódma generacja jednostek TPU od Google. Dokładne porównanie możecie prześledzić w udostępnionej przez Microsoft tabeli:

Surowa moc obliczeniowa to nie jednak wszystko. Dla nowoczesnej AI kluczowa jest także szybkość dostarczania danych do procesora. Aby to zaadresować, w Maia 200 zastosowano całkowicie przeprojektowany system pamięci. Dysponuje on 216 GB pamięci HBM3e o przepustowości sięgającej 7 TB/s oraz 272 MB wbudowanej pamięci SRAM. System ten wspierany jest przez wyspecjalizowane silniki ruchu danych, dedykowane mechanizmy DMA oraz unikalną strukturę NoC (Network-on-Chip). Dzięki takiemu podejściu duże modele językowe (LLMs) są stale "zasilane" danymi, co przekłada się na wysoką utylizację sprzętu i płynne generowanie tokenów bez przestojów.

Maia 200 staje się integralną częścią heterogenicznej infrastruktury chmurowej Microsoftu i ma obsługiwać najbardziej wymagające modele, w tym najnowsze GPT-5.2 od OpenAI. Wdrożenie tego akceleratora ma przynieść wymierne korzyści dla klientów Microsoft Foundry oraz użytkowników Microsoft 365 Copilot, oferując o 30% lepszy stosunek wydajności do ceny w porównaniu z najnowszym sprzętem oferowanym dotychczas przez giganta. Z potencjału nowej architektury skorzysta również wewnętrzny zespół Microsoft Superintelligence, który wykorzysta akceleratory do generowania danych syntetycznych oraz w procesach uczenia przez wzmacnianie (reinforcement learning). Specyficzna konstrukcja układu pozwoli też osiągnąć lepsze wyniki trenowania kolejnych generacji modeli.

Ta nowa technologia wykracza poza pojedynczy chip. Microsoft wprowadził innowacyjną, dwupoziomową konstrukcję sieciową opartą na standardzie Ethernet, która eliminuje konieczność stosowania własnościowych, kosztownych rozwiązań. Każdy akcelerator oferuje 2,8 TB/s dedykowanej, dwukierunkowej przepustowości, co pozwala na budowę klastrów liczących nawet 6144 jednostek. Ich ujednolicony system komunikacyjny, wykorzystujący protokół transportowy Maia AI, umożliwia skalowanie od węzłów przez szafy serwerowe aż po całe klastry.

Proces wdrażania Maia 200 jest równie imponujący jak jej specyfikacja. Dzięki zastosowaniu zaawansowanych środowisk pre-krzemowych, które modelowały zachowania modeli LLM z wysoką dokładnością jeszcze przed wyprodukowaniem fizycznych chipów, Microsoft zdołał skrócić czas od otrzymania pierwszych partii procesorów do ich pełnego wdrożenia w centrach danych o ponad połowę w stosunku do standardowych programów tego typu. Pierwsze jednostki pracują już w Microsoft Cloud w regionie US Central w pobliżu Des Moines w stanie Iowa, a wkrótce dołączy do nich region US West 3 w Arizonie. System został w pełni zintegrowany z płaszczyzną kontrolną Azure, oferując natywne bezpieczeństwo, telemetrię i diagnostykę na każdym poziomie – od chipu po całą szafę serwerową.

Z nowej technologii będą mogli skorzystać deweloperzy. Microsoft przygotował dla nich pakiet narzędzi programistycznych Maia SDK, który jest obecnie dostępny w wersji zapoznawczej. Obejmuje on pełną integrację z frameworkiem PyTorch, kompilator Triton oraz bibliotekę zoptymalizowanych kerneli. SDK daje programistom precyzyjną kontrolę nad sprzętem poprzez dostęp do niskopoziomowego języka programowania Maia, ułatwiając jednocześnie przenoszenie modeli między różnymi akceleratorami sprzętowymi. W pakiecie znajdują się też symulator oraz kalkulator kosztów, umożliwiające optymalizację kodu na wczesnym etapie jego powstawania.

Microsoft podkreśla, że program Maia ma charakter wielogeneracyjny. Podczas gdy Maia 200 trafia do globalnej infrastruktury chmurowej, w biurach projektowych trwają już prace nad kolejnymi generacjami, które mają wyznaczać nowe standardy w dziedzinie najbardziej wymagających obciążeń AI. Obecnie gigant zaprasza deweloperów, start-upy oraz środowiska akademickie do dołączenia do programu testowego SDK, aby wspólnie eksplorować możliwości, jakie otwiera ta nowa era chmurowej mocy obliczeniowej.