Microsoft Phi to mały model językowy (SLM) powstały z myślą o wdrażaniu AI bezpośrednio na urządzeniach, bez konieczności łączenia się z chmurą. Jest dostępny jako Open Source na licencji MIT. Pierwsza wersja publicznie dostępna to Phi-3, a później pojawiły się jeszcze Phi-3.5, Phi-4 oraz ich warianty. Najnowszy z nich osiągnął niebywałą wydajność. Do czego może się przydać sztuczna inteligencja na urządzeniu?

Phi-4-mini-flash-reasoning to najnowsza wersja modelu AI od Microsoft, który wyróżnia nowa architektura i wysoka wydajność. Model został zoptymalizowany do działania w środowiskach o ograniczonych zasobach. Jak sama nazwa wskazuje, jest to model wnioskujący/rozumujący, który dobrze radzi sobie z matematyką i problemami logicznymi. Może działać na urządzeniach brzegowych (czyli po drugiej stronie chmury), m.in. zamieniając zwykłe aplikacje mobilne w aplikacje AI.

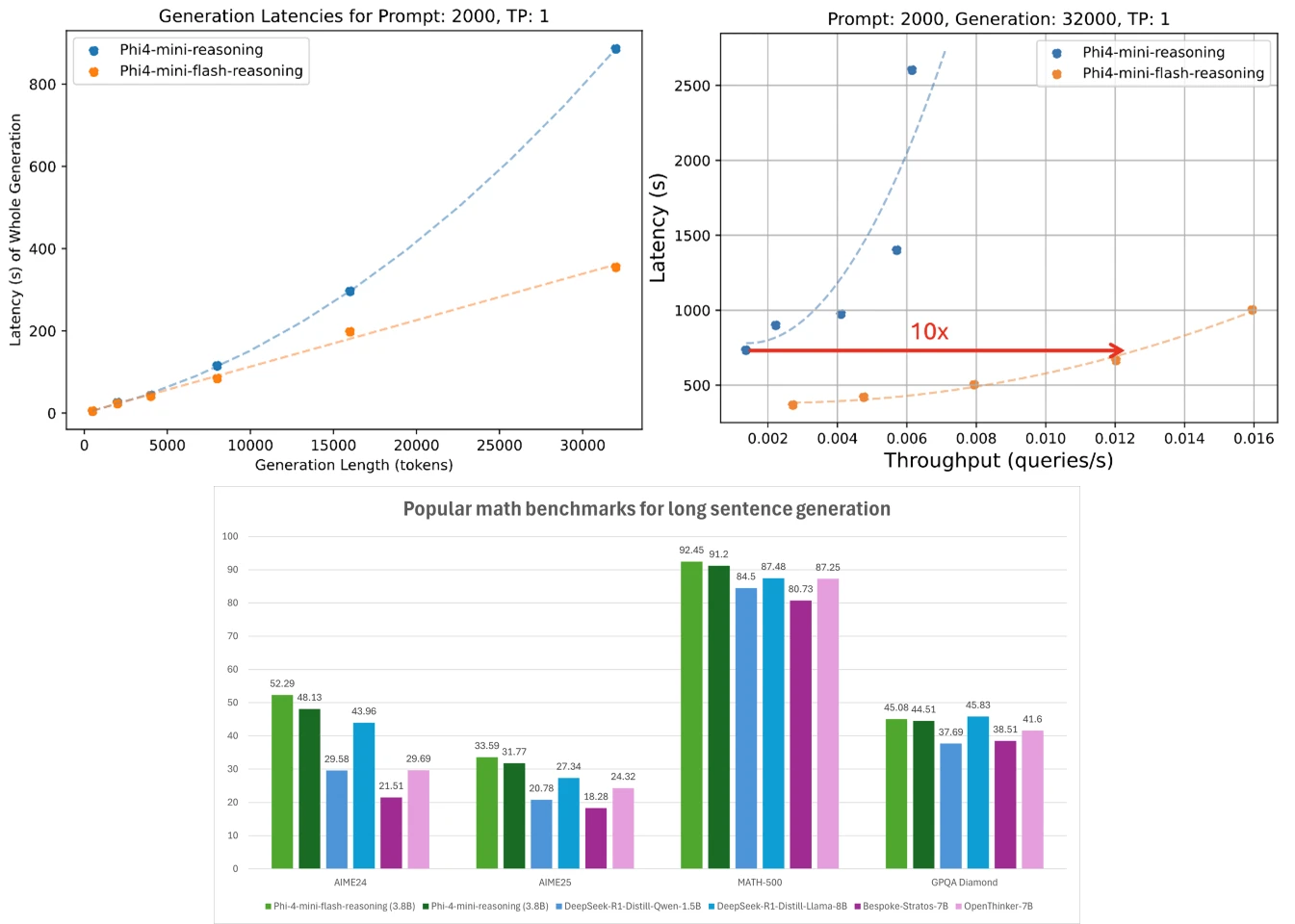

Ten nowy model bazuje na Phi-4-mini, ale opiera się na nowej architekturze hybrydowej, która osiąga do 10 razy wyższą przepustowość i 2-3 razy niższą latencję, umożliwiając znacząco szybsze wnioskowanie [inference] bez poświęcania wydajności rozumowania [reasoning]. Gotowy do napędzania rozwiązań z prawdziwego świata, które wymagają wydajności i elastyczności, Phi-4-mini-flash-reasoning jest dostępny w Azure AI Foundry, NVIDIA API Catalog i Hugging Face.

— Weizhu Chen, Jianfeng Gao i Liliang Ren z Microsoft

Phi-4-mini-flash-reasoning opiera się na nowej architekturze SambaY, której główną innowację stanowi Gated Memory Unit (GMU), prosty, lecz efektywny mechanizm udostępniania reprezentacji między warstwami. Zastosowane rozwiązania "drastycznie poprawiają wydajność dekodowania, podnosi wydajność pobierania długiego kontekstu i umożliwia architekturze osiągnięcie wyjątkowej wydajności w szerokim zakresie zadań".

Podobnie jak pozostałe modele Phi, tak również ten nowy wariant można wdrożyć na pojedynczym GPU. W odróżnieniu od Phi-4-mini-reasoning osiąga on jednak niższą latencję i wyższą przepustowość, zwłaszcza przy generowaniu długiego kontekstu i zadaniach wykorzystujących wnioskowanie. W benchmarkach Phi-4-mini-flash-reasoning wypada korzystniej nie tylko niż wersja nie-flash, ale też inni rywale o podobnym charakterze.

Do czego go użyć? Deweloperzy mogą zaimplementować Phi-4-mini-reasoning na adaptacyjnych platformach edukacyjnych, dla których ważna jest pętla feedbacku w czasie rzeczywistym, ale też w asystentach AI uruchamianych na urządzeniu, w interaktywnych systemach nauczania, lżejszych symulacjach czy narzędziach do automatycznego oceniania.