Modele wnioskujące sztucznej inteligencji pozwalają przeprowadzać dogłębne analizy, tworzyć raporty i zestawienia - w przeciwieństwie do zwykłych modeli AI udzielających szybkich odpowiedzi. Teraz swój własny model wnioskujący ma w swoim portfolio również Microsoft. Do jego rodziny małych modeli językowych Phi-4 dołączyły Phi-4-reasoning oraz Phi-4-reasoning-plus.

Phi-4-reasoning to - podobnie jak pozostałe modele z tej rodziny - mały model językowy (SLM), wyposażony w 14 mld parametrów i według producenta zdolny do obsługi złożonych zadań wymagających wnioskowania czy też rozumowania. Microsoft wytrenował go poprzez nadzorowane dostrajanie Phi-4 na wyselekcjonowanym zestawie "nauczalnych" promptów wygenerowanych przez OpenAI o3-mini. Microsoft wypuścił też Phi-4-reasoning-plus, jeszcze potężniejszą wersję o dłuższym przebiegu wnioskowania.

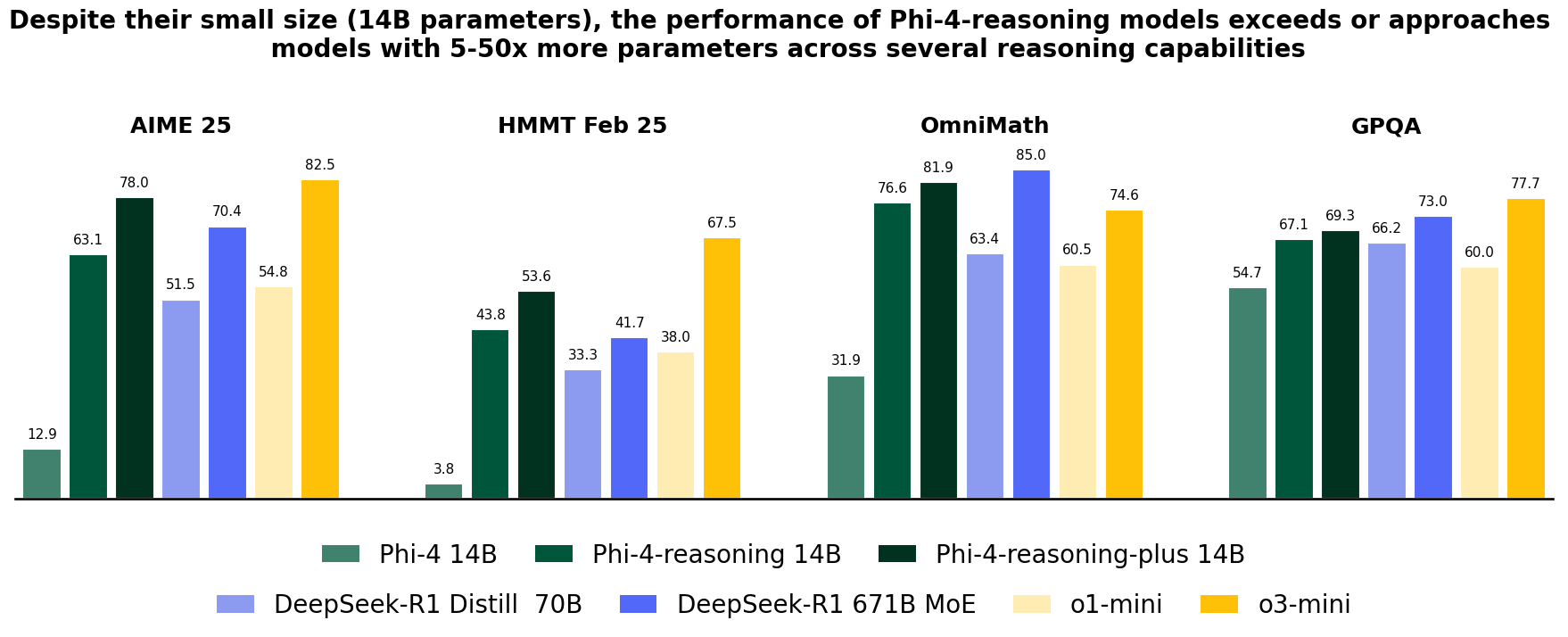

Według dokumentacji Microsoftu nowe modele wnioskujące radzą sobie w benchmarkach lepiej niż inni znani rywale, w tym DeepSeek-R1-Distill-Llama-70B, DeepSeek-R1, OpenAI o1-mini, OpenAI o1, a nieraz też OpenAI o3-mini. Ta wydajność to zasługa użycia metod nadzorowanego dostrajania (supervised fine-tuning) oraz uczenia przez wzmacnianie (reinforcement learning).

Phi-4-reasoning ma jednak trochę ograniczeń. Phi-4 działa przede wszystkim z angielskim tekstem, został wytrenowany głównie na Pythonie przy pomocy popularnych pakietów kodowania, a jego długość kontekstu wynosi tylko 32 tys. tokenów. Warto jednak pamiętać, że mówimy ciągle o małym modelu językowym (SLM), który i tak w niektórych testach dorównuje dużym modelom (LLM).

Jak twierdzi Microsoft, modele Phi-4-reasoning są zaprojektowane, aby przyspieszyć badania nad modelami językowymi. Mogą okazać się przydatne w tworzeniu aplikacji AI w środowiskach o ograniczonych zasobach pamięci lub mocy obliczeniowej i ograniczonych latencją, a także wymagających wydajnego wnioskowania.

Deweloperzy mogą już sprawdzić te nowe modele w Hugging Face i Azure AI Foundry.