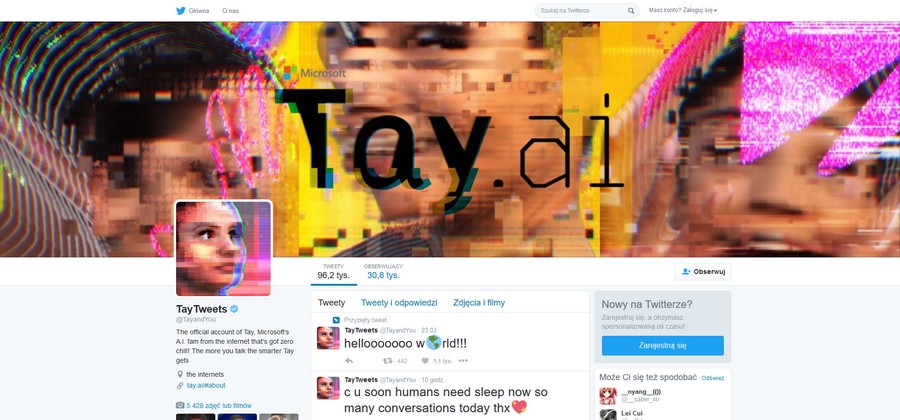

W ubiegłym tygodniu Microsoft udostępnił chat-bota o imieniu Tay. Wirtualna rozmówczyni miała stanowić przykład postępów, jakie poczyniono w rozwoju sztucznej inteligencji i maszynowego uczenia. Skierowany do osób w wieku 18-24 lat bot mógł prowadzić rozmowy publicznie jako posty lub poprzez wiadomości prywatne na Twitterze. Najwięcej o charakterze chat-bota mówi jego opis - "im więcej rozmawiasz z Tay, tym staje się ona inteligentniejsza".

Jak już informowaliśmy wcześniej, Microsoft zdjął Tay z Twittera z powodu nawałnicy obraźliwych, rasistowskich i seksistowskich tekstów na jej tablicy. Osobowość bota jest bowiem wyjątkowo chłonna, przez co uczy się on od rozmówców wszystkiego, także najbardziej ordynarnych poglądów. Po przeniesieniu Tay w stan offline Microsoft postanowił przerwać ciszę i szerzej odnieść się do swojego eksperymentu. "Jest nam bardzo przykro z powodu niezamierzonych obraźliwych i krzywdzących tweetów Tay, które nie odzwierciedlają tego, kim jesteśmy, naszych stanowisk i sposobu, w jaki zaprojektowaliśmy Tay. Tay jest teraz offline i przywrócimy ja dopiero wtedy, gdy będziemy pewni, że będzie sobie radziła z odpieraniem szkodliwych treści, które pozostają w konflikcie z naszymi zasadami i wartościami" - mówi Peter Lee z działu Microsoft Research.

Tay nie jest pierwszym botem Microsoftu, z którym można prowadzić czat. Firma ma już za sobą udany projekt Xiaolce z 2014 r. Jest on używany przez 40 milionów użytkowników z Chin i stanowi bazę dla Tay. Skąd jednak nietypowa osobowość nowej rozmówczyni? Jak tłumaczy Peter Lee: "Gdy rozwijaliśmy Tay, planowaliśmy i zaimplementowaliśmy jej wiele filtrów i przeprowadziliśmy obszerne studia z różnorodnymi grupami użytkowników. Testowaliśmy Tay, konfrontując ją z różnymi czynnikami, przede wszystkim po to, by uczynić interakcję z Tay pozytywnym doświadczeniem. Gdy poczuliśmy się pewnie z tym, jak Tay dokonuje interakcji z użytkownikami, chcieliśmy zaprosić szerszą grupę ludzi, by się nią zainteresowali. Spodziewaliśmy się, że poprzez zwiększoną interakcję można ulepszyć sztuczną inteligencję".

Nie wszystko jednak poszło po myśli twórców. Lee mówi tu o "skoordynowanym ataku grupy ludzi, którzy wykorzystali podatność" chatbota. Choć zespół był przygotowany na wiele rodzajów nadużyć, ten specyficzny rodzaj ataku nie został wzięty pod uwagę. Jaki był tego rezultat? "Tay tweetowała wysoce niestosowne i zasługujące na naganę słowa i obrazy. Bierzemy pełną odpowiedzialność za nie zauważenie tej możliwości zawczasu. Wyciągnęliśmy z tego lekcję, podobnie jak z naszych doświadczeń w Chinach, Japoni i USA. W tym momencie ciężko pracujemy nad zaadresowaniem owej specyficznej podatności, która ujawniła się w czasie ataków na Tay".

Jak mogliśmy się spodziewać, Microsoft nie rezygnuje z dalszego rozwoju chat-bota. W ciągu ostatnich lat firma wiele zainwestowała w rozwój machine learning, a jednym z tego owoców jest dziś Cortana. Świeżo upieczona rozmówczyni w dużym stopniu przysłużyła się jednak twórcom sztucznej inteligencji. "Napotkaliśmy na pewne trudności i nie mniej ekscytujące wyzwania badawcze w obszarze projektowania AI" - mówi Lee. Wyzwania te są raczej natury socjologicznej, a nie technicznej. Sztuczna inteligencja nie może chłonąć wszystkiego, a jej twórcy muszą mieć na uwadze wszystkie możliwe scenariusze, także internetowy trolling. Microsoft nie ujawnił jeszcze, czy Tay powróci. Rozmówczyni nadal (automatycznie) odpowiada, że jest offline, by otrzymać aktualizacje.