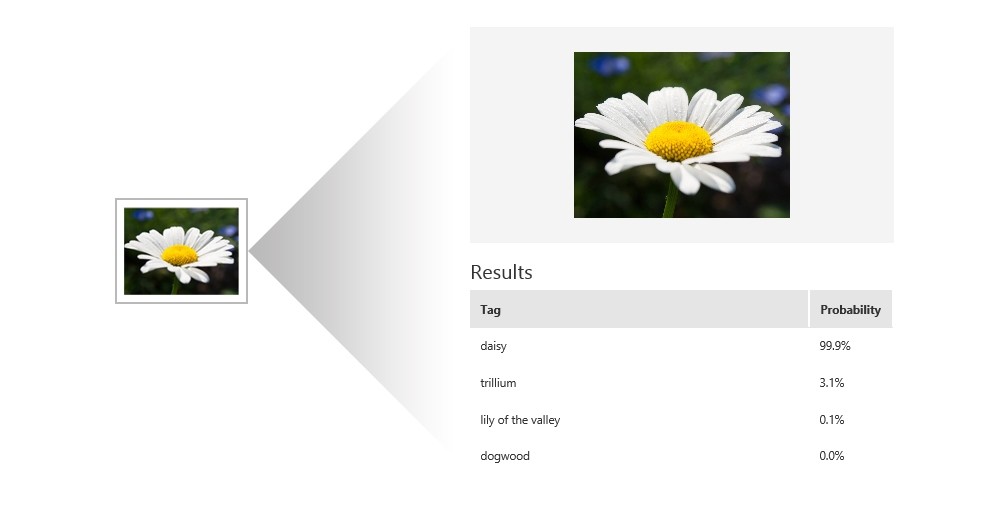

Computer Vision, nazywane też widzeniem komputerowym lub - nieco mniej dosłownie - komputerowym rozpoznawaniem obrazów, to jedna z umiejętności sztucznej inteligencji, zorientowana na rozpoznawanie zawartości obrazów - znajdujących się na zdjęciach czy grafikach obiektów, osób, krajobrazów, symboli, tekstów itd. Proces przypomina nieco znane z przedszkola czy szkoły podstawowej zadania "opisywania obrazków". W zależności od dostępnych algorytmów Computer Vision może z mniejszą lub większą skutecznością rozróżniać te cechy zawartości, na które zostaje ukierunkowane. Inaczej więc działają algorytmy, śledzące ruch drogowy na podstawie obrazu z kamer, inaczej te rozpoznające emocje i wiek na podstawie zdjęć twarzy, a jeszcze inaczej te, które służą za pomoc dla niewidomych i opisują im dźwiękowo cały kontekst sytuacyjny.

W rzeczywistości widzenie komputerowe jest dopiero raczkującą dziedziną, która ma wprawdzie zastosowanie praktyczne, ale daleko jej do umiejętności interpretacji widzianego obrazu, którą posiada choćby kilkuletnie dziecko. O ile człowiek (podobnie jak inne istoty biologiczne) zdolności kognitywne posiada już na starcie lub - jak sądzą niektórzy badacze psychiki - nabywa je w pierwszych miesiącach życia, o tyle komputery trzeba dopiero nauczyć patrzeć i widzieć. Zadanie nie jest wcale łatwe, a wysiłki na tym polu trwają już od kilku dekad. Nie znaczy to jednak, że temat jest nudny. Wręcz przeciwnie, praca nad udoskonaleniem komputerowego wzroku wydaje się niezwykle frapująca. Na pewno wielu z nas ma pytania odnośnie tej niszowej wciąż techniki - w końcu to dopiero rozwijająca się dziedzina. Odpowiedzi na te pytania udzielił dr Gang Hua, główny badacz w Machine Perception and Cognition Group, działającej w Core Computer Vision Technology Center w ramach Microsoft AI and Research Group w Redmond. Mówiąc krótko, Hua jest głównym odpowiedzialnym za maszynową percepcję i rozpoznawanie obrazu w Microsoft.

W ramach Microsoft Research Podcast rozmowę z Gang Hua przeprowadziła Gretchen Huizinga, pytając gościa o ostatnie osiągnięcia na polach AI i machine learningu, w tym w szczególnych obszarach komputerowej wizji, rozumienia wideo, a nawet sztuki. Hua wyjaśnia również specyfikę pracy laboratoryjnej ludzi i maszyn, której celem jest przygotowanie systemów Computer Vision do widzenia i interpretowania otwartego świata. Poniżej zamieszczamy transkrypcję tej rozmowy, jednak z pominięciem mało znaczących fragmentów.

Mówiąc z grubsza, co rano budzi badacza Computer Vision? Co jest wielkim celem?

Tak, widzenie komputerowe to relatywnie młoda dziedzina badawcza. Ogólnie można myśleć, że dziedzina ta stara się budować maszyny, które ufundują komputerom możliwość widzenia świata i interpretowania świata, jak robi to człowiek. Z bardziej technicznego punktu widzenia chodzi o dane wejściowe dla komputera, którymi są obrazy i wideo. Możesz o nich myśleć jak o sekwencji liczb, ale chcemy z tych obrazów i wideo, z tych liczb wydobyć pewien rodzaj struktur świata lub trochę informacji semantycznych. Mógłbym na przykład powiedzieć, że ta część obrazu naprawdę koresponduje z kotem, tamta część koresponduje z samochodem - tego typu interpretacje. Taki jest zatem cel komputerowego widzenia. Dla nas, ludzi, wydaje się to prostym zadaniem do wykonania, ale żeby nauczyć te komputery to robić, musieliśmy osiągnąć sporo postępów w ostatnich 10 latach. Na polu badawczym ta rzecz istnieje już jednak od 50 lat. Nadal jest wiele problemów do rozwiązania i zaadresowania.

Tak, rzeczywiście, przed jakimiś pięcioma godzinami dałeś wykład, w którym mówiłeś - parafrazuję - "Dlaczego po trzydziestu latach badań powinny nas nadal obchodzić badania nad rozpoznawaniem twarzy?". Powiedz nam, jak na to odpowiedziałeś, i jak myślisz, gdzie teraz się znajdujemy.

Myślę, że jakieś pięć lat temu [osiągnęliśmy] status quo, i powiedziałbym, że na ten moment, jeśli zarejestrujemy migawkę tego, jak rozwinęły się badania nad rozpoznawaniem twarzy od początków widzenia komputerowego czy badań nad rozpoznawaniem twarzy, powiedziałbym, że osiągnęliśmy wiele. Ale wiele w kontrolowanych warunkach, gdzie możesz ostrożnie kontrolować oświetlenie, aparaty, ustawienia i wszystkie te rzeczy, gdy kadrujesz twarze. Na ten moment, pięć lat temu, gdy poszliśmy w kierunku bardziej dzikich ustawień, jak twarze w ich niekontrolowanych warunkach, powiedziałbym, że istnieje ogromna luka w zakresie skuteczności rozpoznawania. Powiedziałbym jednak, że w ostatnich pięciu latach cała społeczność poczyniła ogromne postępy, używając bardziej zaawansowanych, deep learningowych technik. Osiągnęliśmy duże postępy nawet w tym dzikim scenariuszu rozpoznawania twarzy i doprowadziliśmy te rzeczy do stanu, w którym mogło zaistnieć wiele aplikacji komercyjnych.

Ok, zatem deep learning naprawdę umożliwił, nawet ostatnio, trochę świetnych postępów na polu komputerowego widzenia i komputerowego rozpoznawania obrazów.

Prawda.

To interesujące, kiedy mówisz o różnicach między wysoce kontrolowanymi sytuacjami w zestawieniu z rozpoznawaniem rzeczy w dziczy. Miałam tu kilku badaczy, którzy mówili, że komputery zawodzą, kiedy zestawy danych nie są do końca pełne. Przykładowo: pies, pies, pies, trójnożny pies, mmm, to nadal jest pies?

Jasne.

Prawda? Więc jakiego rodzaju rzeczy dają Ci techniki deep learningowe, których nie miałeś przed tymi osiągnięciami w rozpoznawaniu?

Tak, to świetne pytanie. Z perspektywy badacza, wiesz, moc deep learningu ukazuje kilka efektów. Pierwszą rzeczą jest to, że może on przewodzić uczenie w stylu end-to-end i uczyć się tego, co jest właściwą reprezentacją wzoru semantycznego. Przykładowo, kiedy mówimy o psie, kiedy rzeczywiście przeglądasz te wszystkie zdjęcia psa, jeśli moje dane wejściowe to naprawdę obrazy 64×64, załóżmy, że każdy piksel ma 250 wartości do przyjęcia. To ogromna przestrzeń, jeśli myślisz o tym w kategoriach kombinatoryki. Kiedy jednak mówimy o psie jako o wzorze, wtedy każdy piksel jest trochę skorelowany, więc właściwy wzór "psa" będzie rezydował w przestrzeni nieco mniej wymiarowej. Moc deep learningu jest więc taka, że mogę postępować z uczeniem w stylu end-to-end, które rzeczywiście uczy się właściwej numerycznej reprezentacji "psa". I ze względu na głębokie struktury możemy wyjść z bardziej skomplikowanymi modelami, które są w stanie przetrawić większe ilości danych treningowych. Oznacza to więc, że jeśli moje dane treningowe pokrywają wszystkie rodzaje wariacji - jak wszystkie rodzaje widoków tego wzoru - w końcu mogę rozpoznać to w szerszym ustawieniu, ponieważ pokryłem niemal wszystkie przestrzenie. Ok, więc kolejną możliwością deep learningu jest ten rodzaj zachowania kompozycyjnego, ponieważ to warstwa, pasuje do struktury i warstwy reprezentacji, więc gdy informacja lub obraz pasuje do głębokich sieci [neuronowych] i zaczyna od ekstrakcji pewnych niskopoziomowych obrazowych prymitywów, wówczas stopniowo model może zgromadzić wszystkie te prymitywy do kupy i uformować wyższe i coraz wyższe poziomy struktur semantycznych. W tym sensie przechwytuje on wszystkie te niewielkie wzory, korespondujące z większymi wzorami, i komponuje je razem, by reprezentowały finalny wzór. Dlatego jest to bardzo potężne, zwłaszcza dla rozpoznawania obrazu, więc tak.

Zatem szeroki parasol CVPR obejmuje rozpoznawanie wzorów w widzeniu komputerowym.

Tak, dokładnie.

A wiele z tego rozpoznawania wzorów jest tym, do czego dążą te techniki.

Dokładnie, tak. Więc to naprawdę, komputerowe widzenie naprawdę próbuje wyciągnąć sens z pikseli. Gdy mówimy o tym w sposób mechaniczny, wchodzę w obraz. Wydobywasz z tego pewne numeryczne albo symboliczne dane wyjściowe. Dane numeryczne, przykładowo, mogą być trójwymiarową chmurą punktową, która opisuje strukturę sceny albo kształty obiektu. Może też korespondować z pewnymi etykietami semantycznymi, jak kot i pies, jak wspomniałem na początku.

Dotarliśmy do etykietowania. To interesujące, że cała część procesu machine learningowego musi być karmiona tak etykietami, jak i pikselami, prawda?

Jasne, tak.

Masz trzy główne obszary zainteresowań w badaniach nad widzeniem komputerowym, o których rozmawialiśmy: Wideo, twarze oraz sztuka i media. Porozmawiajmy o każdym z nich po kolei i zacznijmy od twoich obecnych badań nad tym, co nazywasz "rozumieniem wideo".

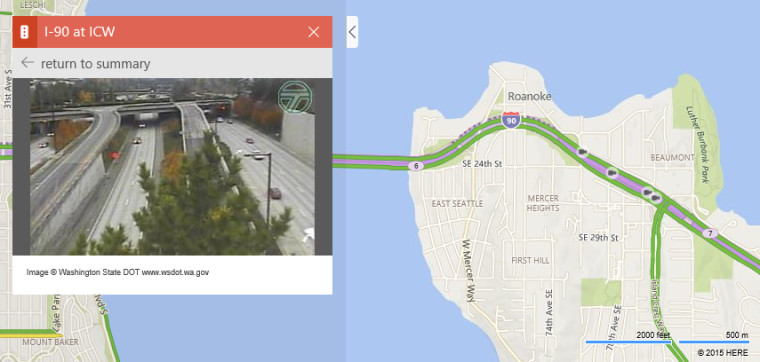

Tak, rozumienie wideo - nazwa wszystko wyjaśnia. Sygnałem wejściowym staje się strumień wideo. Zamiast pojedynczego obrazu rozumowanie dotyczy pikseli i tego, jak się poruszają. Jeśli postrzegamy rozumowanie Computer Vision o pojedynczym obrazie jako problem z zakresu rozumowania przestrzennego, to teraz mówimy o problemie rozumowania przestrzenno-temporalnego, ponieważ wideo jest trzecim wymiarem lub wymiarem czasowym. Jeśli spojrzymy na wiele problemów prawdziwego świata, mówimy o nieprzerwanych strumieniach wideo, czy to z kamer monitoringu na budynkach, czy z kamer nadzorujących ruch na autostradach. Masz ten nieprzerwany strumień ramek, który się pojawia, i poruszających się w nich obiektów. Chcesz z niego po prostu wydobyć informacje.

Kiedy mówisz o tych rodzajach kamer, dają nam one olbrzymie ilości [danych] wideo, wiesz, o stałym strumieniu kamer i ochrony w 7-Eleven i tego typu rzeczach. Co twoja grupa stara się zrobić dla ludzi z tymi strumieniami wideo?

Jasne. Więc jest jeden projekt inkubacyjny, który robimy. Mój zespół buduje tam podstawową technologię. Jeden projekt inkubacyjny, który staramy się zrobić, analizuje ruch na drogach. Kiedy myślisz o mieście, kiedy podpinają tam wszystkie te kamery ruchu drogowego, większa część obszaru tych strumieni wideo właściwie się marnuje. Jeśli jednak pomyślisz o tym uważnie, te kamery są inteligentne. Pomyśl o takim scenariuszu, gdzie chcesz inteligentniej kontrolować światła drogowe. Więc jeśli widzę z jednej strony większy napływ ruchu, to [można go użyć] zamiast stałego harmonogramu włączania i wyłączania tych czerwonych i zielonych świateł. Powiedziałbym "Ok", ponieważ ta strona ma mniej samochodów czy nawet żadnych samochodów w tym momencie, pozwoliłbym utrzymać zielone światło dla innych kierunków, dzięki czemu płynność ruchu jest lepsza. To tylko jeden z typów takich aplikacji.

Jasne, bo przecież ilu z nas musiało stać na czerwonym, kiedy nic nie jechało z innej strony.

Dokładnie.

Wtedy myślisz - czemu nie mogę jechać?

Jasne. Tak, możesz też pomyśleć o innych aplikacjach, gdybyśmy zgromadzili nagrania przez lata, gdyby obywatele prosili o przygotowanie dodatkowych pasów dla rowerów, moglibyśmy użyć tych nagrań, przeanalizować wszystkie dane o ruchu i wtedy zdecydować, czy ma sens budowa tam pasa dla rowerów. Jeśli go ustawimy, moglibyśmy jak gdyby wpłynąć na inne przepływy ruchu i pomóc miastom podejmować tego typu decyzje.

Myślę, że to świetne, bo bardzo często podejmujemy decyzje w oparciu o, no wiesz, nasze własne idee zamiast w oparciu o dane, które mówią: hej, tutaj pas dla rowerów byłby świetny. To przez to wszystko jest rujnowane dla wszystkich, prawda?

Jasne, tak. Oni czasem używają paru innych typów sensorów, by to zrobić. Zatrudniasz firmę, żeby podpięła specjalne wyposażenie na drogach, które to robi. Ale jest to bardzo nieefektywne finansowo. Pomyśl o wszystkich tych kamerach, które tam tkwią. O tych strumieniach wideo. Prawda?

Tak, to fantastyczne wyjaśnienie tego, co możesz zrobić z machine learningiem i rozumieniem wideo.

Racja.

Tak, kolejny obszar, który cię interesuje, to twarze i powrót do "dlaczego powinny nas nadal obchodzić badania nad rozpoznawaniem twarzy?".

Jasne.

Ta linia badawcza ma parę naprawdę ciekawych aplikacji. Pomówmy o tym, co dzieje się w badaniach nad rozpoznawaniem twarzy. Kto je robi i co nowego?

Tak, więc istotnie, jeśli spojrzymy wstecz, technologia rozpoznawania twarzy zaliczyła w Microsoft postępy. Myślę, że kiedy byłem w Live Labs Research, skonfigurowaliśmy pierwszą bibliotekę rozpoznawania twarzy, której mogły używać różne zespoły produktów. Istotnie, pierwszy zaadaptował ją Xbox. Próbowali wtedy użyć technologii rozpoznawania twarzy, by zautomatyzować logowanie użytkownika. Myślę, że to była pierwsza adaptacja. W międzyczasie centrum [tych badań] migrowało do Microsoft Research Asia, gdzie nadal mamy grupę badaczy, z którymi współpracuję. Cały czas próbujemy wycisnąć z tego dzieło sztuki. Stało się to teraz synergicznym wysiłkiem, gdzie mamy zespoły inżynierów, pomagających nam zdobyć więcej danych i potem trenujemy lepsze modele. Nasze badania ostatnio były w zasadzie bardziej skupione na linii badawczej, którą nazywamy zachowującą-tożsamość syntezą twarzy [identity-preserving face synthesis]. Ostatnio były też duże osiągnięcia w społeczności deep learning wraz z ukonstytuowaniem użycia głębokich sieci dla modeli generatywnych, które mogą modelować dystrybucję obrazów, dzięki czemu można czerpać z tej dystrybucji, zasadniczo syntezować obraz. Budujesz głębokie sieci, których danymi wyjściowymi jest obraz. To, co chcemy osiągnąć, jest właściwie o krok dalej. Chcemy syntezować twarze. Podczas gdy chcemy zachować tożsamość tych twarzy, nie chcemy, aby nasze algorytmy po prostu losowo próbkowały zestaw twarzy bez jakiejkolwiek informacji semantycznej. Powiedzmy, że chcesz wygenerować twarz Brada Pitta. Naprawdę chcę wygenerować twarz, która wygląda jak Brad Pitt. Chcę generować twarz podobną do kogokolwiek, kogo znam. Myślę, że chcemy po prostu być w stanie to osiągnąć.

Zachowanie tożsamości jest więc wynikiem docelowym dla osoby, której twarz chcesz wygenerować?

Właśnie.

Odbiegając od tematu, zastanawiam się, czy ta technologia będzie zmieniała się płynnie wraz z tobą, gdy będziesz stawał się starszy, i zacznie cię rozpoznawać, czy będziesz musiał aktualizować swoją twarz?

Powiedziałbym, że generalnie trwają już u nas badania, które próbują uporać się z tym problemem. Myślę, że dla dzisiejszej technologii - tak, musisz zaktualizować swoją twarz od czasu do czasu. Zwłaszcza kiedy doświadczyłaś wielu zmian, jak przykładowo ktoś, kto przeszedł jakieś operacje plastyczne. To w zasadzie łamie obecny system.

Chwila, to nie ty.

Jasne, to w ogóle nie ja. Więc istnieje parę sposobów, by o tym myśleć. Twarze ludzkie nie zmieniają się zbytnio od wieku 17-18 lat, gdy jesteśmy dorośli, aż do - być może - pięćdziesiątki. Więc kiedy ludzie się rodzą, są dziećmi. Ich twarze zmieniają się bardzo z powodu rosnących kości i kształt skóry może się mocno zmienić. Ale kiedy ludzie dojrzewają do stanu dorosłości, zmieniają się bardzo powoli. Mamy pewne badania, trenujemy też modele pod kątem procesów starzenia, co pozwoli ustanowić lepsze systemy rozpoznawania twarzy dla różnych wieków. To bardzo dobry rodzaj technologii, która pozwoli ci przykładowo wejść do domeny organów ścigania, jakieś zaginione dzieci, które mogą być przez kogoś porwane, ale po wielu latach...

Mogą wyglądać inaczej.

Tak, wyglądają inaczej. Jeśli algorytmy inteligentnego rozpoznawania twarzy mogą dopasować oryginalne zdjęcia...

I powiedzieć, jak wyglądałyby w wieku np. 14 lat, jeśli zostały porwane wcześniej lub coś w tym stylu?

Tak, tak, dokładnie.

Wow, to świetna aplikacja. Dobrze więc, porozmawiajmy o innych obszarach, w których się aktywnie realizujesz, a są to media i sztuki. Powiedz nam, jak sztuka, badania i twoja konkretna praca na siebie nachodzą w głębokim artystycznym transferze stylu.

Popatrzmy na potrzeby ludzi. Najpierw musimy jeść, potem musimy pić, potem musimy spać. Ok? Gdy wszystkie te potrzeby zostaną zaspokojone, my, ludzie, mamy silną potrzebę sztuki...

I tworzenia.

I tworzenia, i rzeczy tego typu. Ten temat w badaniach nad widzeniem komputerowym, jeśli połączymy go z bardziej artystycznym typem tego, co nazywamy mediami i sztukami, chodzi o użycie technologii widzenia komputerowego, by dać ludziom dobrą, artystyczną rozrywkę. Ten konkretny projekt badawczy, który robiliśmy przez ostatnie dwa lata, jest sekwencją algorytmów, gdzie możemy renderować obraz w dowolnym rodzaju stylu artystycznego - wystarczy tylko dostarczyć przykład tego stylu artystycznego. Przykładowo możemy wyrenderować obraz w stylu Van Gogha.

Van Gogha?

Tak, albo w stylu jakiegokolwiek innego malarza.

Renoit albo Monet... albo Picasso.

Tak, ich wszystkich. Możesz pomyśleć o...

Ciekawe. Za pomocą pikseli.

Za pomocą pikseli, tak. To wszystko ponownie jest robione przez głębokie sieci i pewne technologie deep learningowe, które zaprojektowaliśmy. W pewnym sensie naszym celem jest tworzenie - wiesz, dzieła sztuki są niekoniecznie dostępne dla każdego. Niektóre z nich są bardzo drogie. Poprzez ten rodzaj technologii chcemy uczynić ten rodzaj dzieł sztuki powszechnie dostępnym dla użytkownika.

By demokratyzować.

Tak, zdemokratyzować to, jak wspomniałaś.

To dobrze.

Nasz algorytm pozwala nam budować wyraźne reprezentacje, numeryczne reprezentacje każdego rodzaju stylu. Następnie, jeśli chcesz stworzyć nowe style, możesz je mieszać. Budujemy jak gdyby przestrzeń artystyczną, którą możemy eksplorować od środka, by zobaczyć, jak te efekty wizualne ewoluują pomiędzy dwoma malarzami i tego typu rzeczy. Mamy nawet głębsze rozumienie tego, jak komponowali oni swoje style artystyczne i tego typu rzeczy.

New #AI-powered style transfer techniques from Microsoft are making it easier to make #art from #photos & #video https://t.co/JWMAbgh3xN pic.twitter.com/hyI85M0c3n

— Microsoft Research (@MSFTResearch) 28 lipca 2017

Dla mnie naprawdę interesujące jest to, jak bardzo ta dziedzina jest złożona - informatyka, algorytmy, sporo matematyki i liczb. I jest tu też sztuka, co jest znacznie bardziej metafizyczne. A jeszcze złożenie tego do kupy ujawnia artystyczną stronę złożonego mózgu.

Jasne. Myślę, że aby zebrać te wszystkie rzeczy, największym narzędziem, z którego korzystamy, jest statystyka. Jako że wszystkie rodzaje machine learningu mają z nią do czynienia, chodzi o próby przechwycenia statystyki pikseli.

W twojej niedawno publikowanej pracy - którą nasi słuchacze mogą znaleźć zarówno na stronie MSR, jak i na twojej stronie - mówiłeś o nowym podejściu rozproszonego zestawu do aktywnego uczenia. Powiedz nam, czym to się różni, jakie są tego obietnice?

Kiedy mówimy o aktywnym uczeniu, odnosimy się do procesu, w który to proces uczenia zaangażowany jest pewien rodzaj ludzkiej wyroczni. Widzimy to w tradycyjnym aktywnym uczeniu. Mam uczącą się maszynę. Ta maszyna potrafi inteligentnie wybrać pewne próbki danych i poprosić ludzką wyrocznię o dostarczenie trochę większej ilości danych wejściowych - np. etykiety dla obrazu. Jeśli mówimy o zestawie maszyn, mamy do czynienia z bardziej skomplikowanym problemem. Staramy się wprowadzić aktywne uczenie w środowisko crowd-sourcingowe. Amazon Mechanical Turk jest dziś jedną z największych platform, w której ludzie wysyłają swoje dane i proszą pracowników o oznaczenie ich wszystkich, ale w tym procesie, jeśli nie jesteś ostrożny, etykiety, które zostały połączone w tym procesie, mogą być dość kiepskie. Mogą nie być zdatne do użycia przez ciebie. W tym procesie próbujemy osiągnąć dwa cele. W pierwszym chcemy inteligentnie rozproszyć dane, by etykietowanie było najbardziej efektywne pod względem kosztów. W drugim chcemy oszacować jakość wszystkich pracowników, by nawet w procesie online można było wysłać dane do dobrego pracownika w celu oznaczenia. Tak działa nasz model. Każdy pracownik koresponduje z jedną z tych uczących się maszyn. Staramy się sprawdzić statystycznie te modele, więc w tym samym procesie mamy w locie ocenę statystyczną każdego pracownika. Możemy używać tego modelu nie tylko, by wybierać próbki, ale też wysyłać dane do etykietujących wyższej jakości. W ten sposób, dzięki postępom w etykietowaniu, mogę szybko uzyskać dobry model.

Prowadzi mnie to do problemu human-in-the-loop i konieczności sprawdzania równowagi między ludźmi i maszynami. Abstrahując od tego, o czym mówiłeś, jak podchodzisz do innych problemów związanych z kontrolą jakości, używając ludzi z twoimi maszynami?

Myślałem przez pewien czas o tym problemie, głównie w kontekście robotyki. Kiedy myślisz o jakimkolwiek inteligentnym systemie, to powiedziałbym, że o ile nie jest to naprawdę konfiguracja zamknięta, możesz mieć system, który działa w pełni autonomicznie, ale kiedykolwiek trafiamy w otwarty świat... Obecne inteligentne systemy oparte na machine learningu nie są koniecznie dobre w radzeniu sobie ze wszystkimi przypadkami ze świata otwartego, ponieważ są też przypadki specjalne, które nie zostały objęte.

I zmienne, o których nie pomyślałeś.

Dokładnie. Myślałem o tym, jak moglibyśmy zaangażować ludzi w tę pętlę nie tylko po to, by pomóc inteligentnemu agentowi, gdy tego potrzebuje, ale też aby w tym samym czasie uformować pewien mechanizm, przez który moglibyśmy nauczyć tych agentów radzić sobie z podobnymi sytuacjami w przyszłości. Dam ci konkretny przykład. Kiedy byłem na Stevens Institute of Technology, miałem projekt z NIH, który nazywaliśmy ko-robotami.

Co to za roboty?

Ko-roboty. To właściwie roboty na wózkach inwalidzkich. Idea jest taka, że jeśli użytkownik może poruszać szyją, ma zamontowaną na głowie kamerę, którą może poruszać. Używamy tej kamery, by śledzić pozycję głowy i pozwolić użytkownikowi kontrolować robotykę wózka. Nie chcemy jednak, by użytkownik kontrolował ją przez cały czas. Nasz cel jest taki, że, powiedzmy, chcemy, by w konfiguracji domowej te roboty na wózkach mogły wozić użytkownika i poruszały się w dużej mierze autonomicznie w obrębie pokoju, kiedykolwiek użytkownik je pokieruje, mówiąc "Hej, chcę iść do tamtego pokoju". Wtedy robot na wózku może nawigować w dużej mierze autonomicznie, ale jeśli znajdzie się on w sytuacji, której nie zna, co wtedy? Przykładowo, jak objechać? W takiej chwili prosimy roboty, by proaktywnie poprosiły użytkownika o przejęcie kontroli. Użytkownicy kontrolują wtedy robota i radzą sobie z sytuacją. Może następnym razem roboty znajdą się w podobnej sytuacji i będą już sobie mogły z nią poradzić.

Co robiłeś, zanim tu dotarłeś, i jak wylądowałeś w Microsoft Research?

To moja druga kadencja w Microsoft. Jak wspomniałem, pierwsza miała miejsce między 2006 a 2009 rokiem, kiedy byłem w laboratorium o nazwie Live Labs. Na tamtym etapie zakładałem pierwszą bibliotekę rozpoznawania twarzy. Wtedy zostałem trochę przyciągnięty przez świat zewnętrzny. Udałem się do Nokia Research, IBM Research i wylądowałem w Stevens Institute of Technology jako wykładowca. Później, w 2015 r., wróciłem do Microsoft Research, ale najpierw w Beijing Lab. Przeniosłem się z powrotem w 2017 r., bo moja rodzina tu została.

Zadaję to pytanie wszystkim badaczom, którzy wzięli udział w podcaście, i tobie też je zadam. Czy jest coś w twojej pracy, czym powinniśmy się martwić? Mam na myśli cokolwiek, przez co nie możesz spać.

Powiedziałbym, że zwłaszcza w domenie Computer Vision potencjalnie największą obawą jest prywatność. Kiedy spojrzysz na wszystkie kraje, są tam setki milionów kamer rozstawionych wszędzie w przestrzeni publicznej czy na budynkach. Z całym tym postępem technologicznym to nie science-fiction, by spodziewać się, że te kamery mogą teraz śledzić ludzi przez cały czas. Chodzi mi o to, że wszystko ma dwie strony. Powiedziałbym, że tak, z jednej strony to nam może pomóc, na przykład lepiej radzić sobie z przestępczością. Ale dla zwykłego obywatela istnieje wiele obaw o prywatność.

Więc o jakich rzeczach... Pytam o to, bo mówi to ludziom "Ok, mam tę moc z racji tej świetnej technologii, co może pójść nie tak?". Więc o jakich rzeczach i wdrożeniach - lub implementacjach - możemy myśleć, by nie mieć tego problemu?

Microsoft czyni wielkie starania względem GDPR. Myślę, że to świetnie, bo to mechanizm, który zapewnia, że wszystko, co produkujemy, podlega określonej regulacji. Z drugiej strony wszystko musi osiągnąć równowagę między użytecznością i bezpieczeństwem lub prywatnością. Kiedy o tym myślisz, kiedy używasz jakichś usług online, twoje aktywności zostawiają tam ślady. Jest to używane, by lepiej cię obsłużyć w przyszłości. Ale jeśli chcesz wygody, musisz czasem dać trochę informacji. Ale nie chcesz dać wszystkich swoich informacji, prawda? Myślę, że granice nie są czarno-białe. Musimy to rozważnie kontrolować, dzięki czemu dostajemy odpowiednią ilość informacji, by lepiej obsłużyć klienta, ale nie nieograniczone informacje czy informacje, z których udostępnianiem użytkownik nie czułby się dobrze.

Jako że już kończymy, Gang, powiedz nam o tym, co widzisz na horyzoncie dla następnej generacji badaczy Computer Vision. Jakie są największe nierozwiązane problemy, które mogą doprowadzić do ekscytujących przełomów albo z którymi będziemy się ścierać przez następne 10 lat.

To świetne, ale też ogromne pytanie. Są duże problemy, które powinniśmy podjąć. Obecnie widzenie komputerowe wykorzystuje statystycznie bardzo dużo machine learningu. Możemy trenować modele rozpoznawania, które osiągnęły świetne wyniki. Ten proces jest jednak nadal oparty na powierzchni. Musimy więc lepiej wejść w pewne podstawowe dla Computer Vision sprawy, czyli w geometrię 3D w procesie percepcji. Są też inne rzeczy, zwłaszcza kiedy mówimy o rozumieniu wideo. To problem holistyczny, w którym trzeba wnioskować przestrzenno-temporalnie i musimy być w stanie włączyć więcej koncepcji poznawczych w ten proces, takich jak wnioskowanie przyczynowe. Jeśli coś się wydarza, to co sprawiło, że ta rzecz się wydarza? Techniki machine learningowe głównie mają do czynienia z korelacją między danymi. Korelacja i przyczynowość to dwie różne koncepcje. Myślę więc, że to również musi się wydarzyć. Są też fundamentalne problemy, jak uczenie się na podstawie niewielkich ilości danych i nawet uczenie się z języka, które musimy zaadresować. Pomyśl o tym, jak uczą się ludzie. Uczymy się na dwa sposoby. Uczymy się z doświadczenia, ale jest też inny czynnik. Uczymy się z języka. Przykładowo, kiedy ze sobą rozmawiamy za pomocą języka, nauczyłem się już od ciebie wiele, na przykład...

A ja od ciebie.

Pewnie. Wiesz, to jest bardzo kompaktowy przepływ informacji. Jesteśmy teraz centralnie skupieni na deep learningu. Kiedy spojrzymy 15 lat wstecz, zobaczysz, że społeczność Computer Vision jest bardziej zróżnicowana. Widzisz wszystkie rodzaje metod machine learningowych, widzisz wszystkie rodzaje wiedzy pożyczone z fizyki, z dziedziny optyki, wszystkie sprowadzone do tej dziedziny, by pomogły rozwiązywać problemy z wielu perspektyw. Jako że wszędzie podkreślamy różnorodność, myślę, że społeczność naukowa będzie zdrowsza, jeśli będziemy mieli zróżnicowaną perspektywę i będziemy podchodzić do problemu z wielu perspektyw.

Wiesz, to świetna rada. Ponieważ społeczność wita nowych badaczy, chcemy mieć wielkich myślicieli, myślących szeroko, myślących rozbieżnie, by dążyli do kolejnych wielkich przełomów.

Tak, dokładnie.

Gang Hua, dziękuję za przyjście. To było naprawdę oświecające i naprawdę dobrze mi się rozmawiało.

Bardzo dziękuję.