OpenAI wypuścił nową wersję swojego najmądrzejszego modelu wnioskującego i udostępnił go płatnym użytkownikom ChatGPT oraz deweloperom. Model o3 Pro dłużej pracuje nad odpowiedziami, robiąc bardziej dogłębny research niż modele pierwszego wyboru w darmowych czatbotach. W wielu zadaniach wykazuje też większą skuteczność niż podstawowy o3 (medium), a także o1. Do czego najlepiej jest go używać?

Podobnie jak o1, o3-pro jest wersją naszego najinteligentniejszego modelu o3, zaprojektowanego, aby myśleć dłużej i dostarczać niezawodne odpowiedzi. Od wydania o1-pro użytkownicy preferują ten model w domenach takich jak matematyka, nauki ścisłe i kodowania – obszarach, w których o3-pro nadal się wyróżnia, co pokazały oceny akademickie.

Tak jak o3, o3-pro ma dostęp do narzędzi, które sprawiają, że ChatGPT jest przydatny – może wyszukiwać w sieci, analizować pliki, wnioskować na podstawie danych wizualnych, używać Pythona, personalizować odpowiedzi z użyciem pamięci i nie tylko.

Ponieważ o3-pro ma dostęp do narzędzi, czas jego odpowiadania jest zwykle dłuższy niż w o1-pro. Zalecamy używać go do pytań stanowiących wyzwanie, w których rzetelność jest ważniejsza niż szybkość, a czekanie kilka minut jest warte zachodu.

– OpenAI

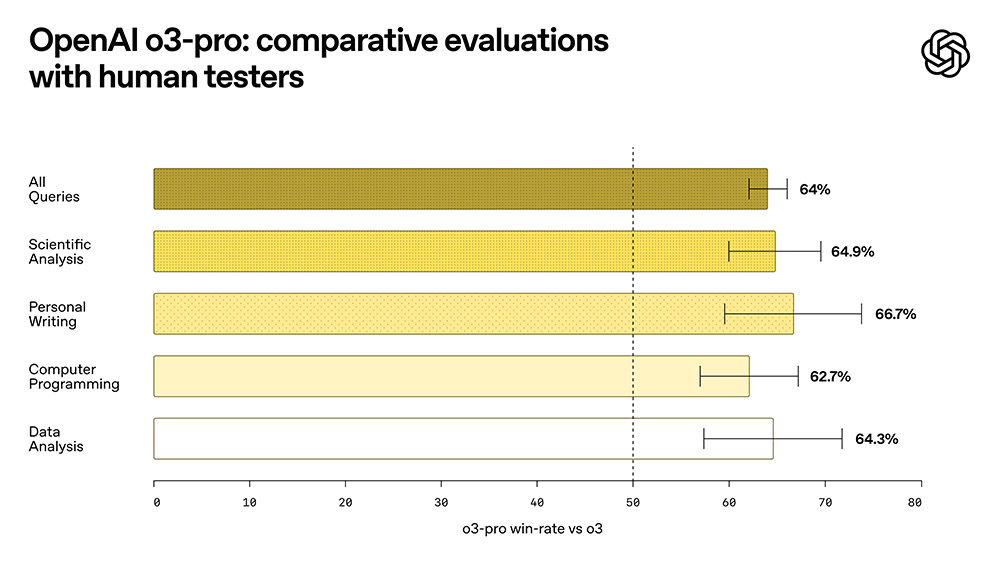

OpenAI udostępnił o3 Pro ekspertom do oceny, a ci preferowali go bardziej niż o3 we wszystkich testowanych kategoriach, wliczając w to analizę naukową, osobiste pisanie, programowanie i analizę danych.

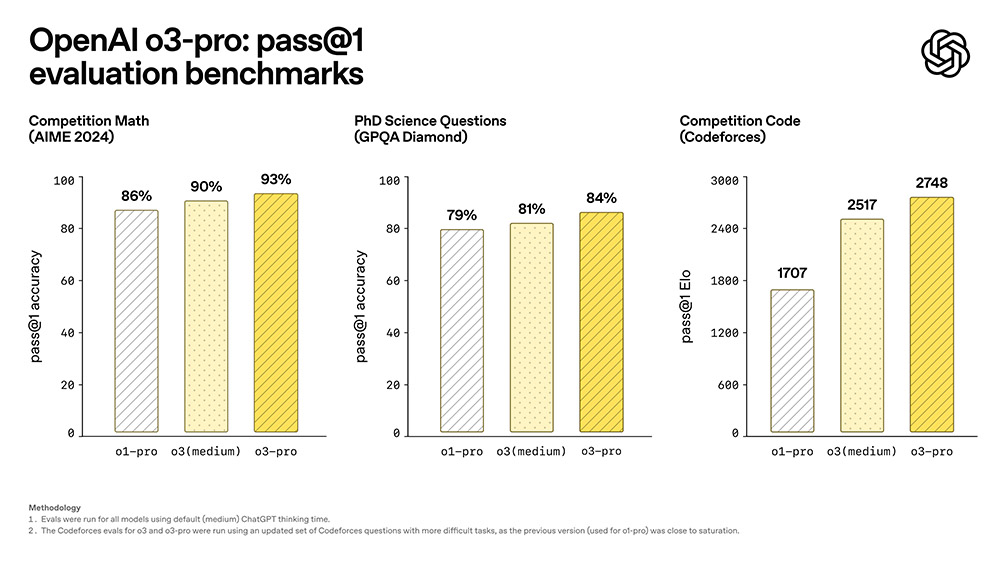

Jak wykazały benchmarki, OpenAI o3 Pro radzi sobie lepiej z zadaniami matematycznymi, pytaniami naukowymi i kodowaniem niż o3 i o1 Pro.

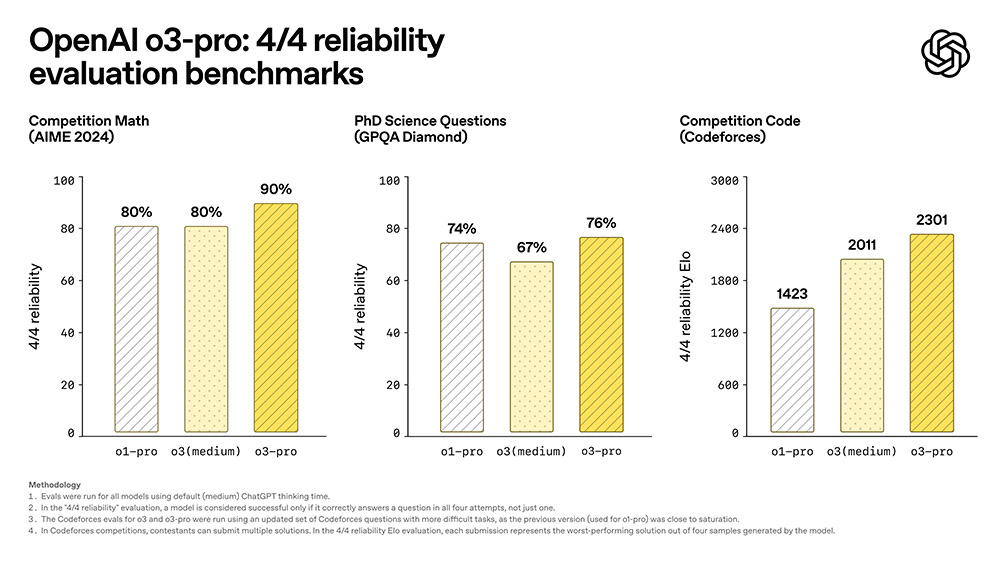

Aby jeszcze lepiej oszacować zdolności o3-pro, OpenAI użył rygorystycznej oceny "niezawodności 4/4", w której model otrzymuje pozytywną ocenę jedynie wtedy, gdy poprawnie odpowie na pytanie we wszystkich czterech próbach, a nie tylko jednej.

OpenAI o3-pro jest już dostępny w przeglądarce modeli ChatGPT Pro i Team, gdzie zastępuje o1-pro. Subskrybenci Enterprise i Edu uzyskają do niego dostęp w przyszłym tygodniu. Z modelu mogą też korzystać deweloperzy poprzez API, aby implementować go w swoich aplikacjach AI.