W maju tego roku OpenAI ogłosiło GPT-4o, następny duży model językowy (LLM) promowany jako dwa razy szybszy i o połowę tańszy od GPT-4 Turbo. Wkrótce jednak okazało się, że to jeden z najdroższych modeli, którego koszt przebija jedynie Claude 3 Opus od Anthropic. W międzyczasie firma zajęła się rozwijaniem bardziej opłacalnych modeli AI.

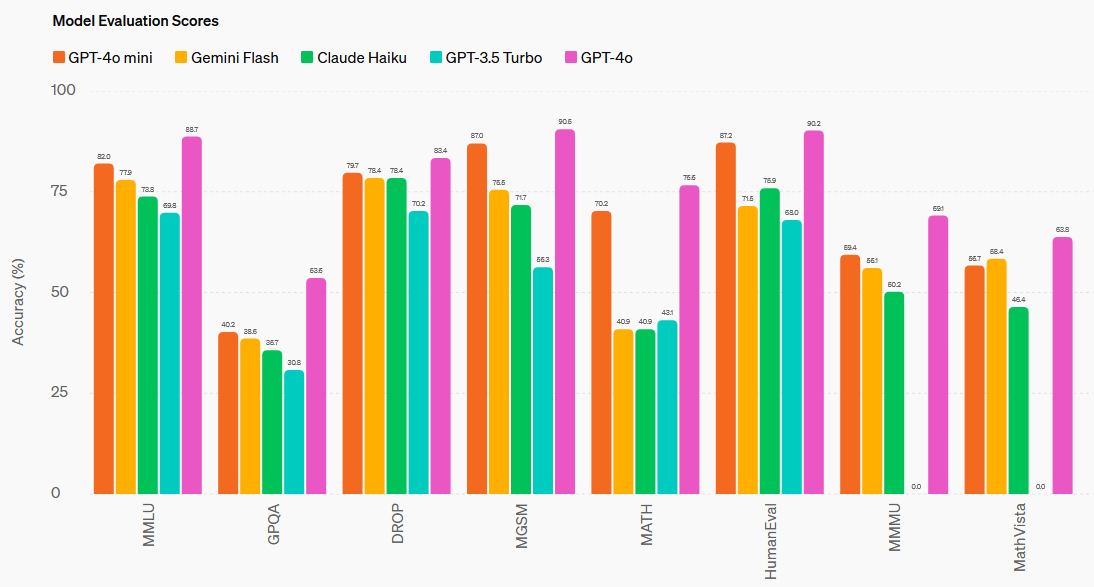

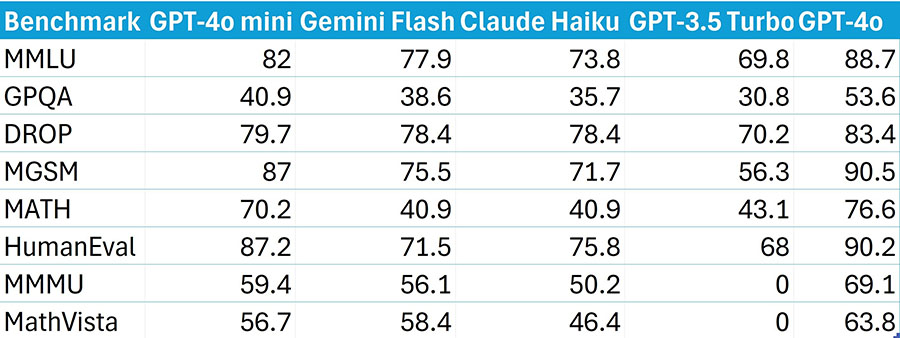

Nad tańszymi dla deweloperów modelami LLM pracowali praktycznie wszyscy liczący się dostawcy, czego efektami są Claude 3 Haiku, Gemini 1.5 Flash oraz ogłoszony wczoraj GPT-4o mini. Będzie on szybszy i tańszy od istniejących modeli OpenAI i zastąpi GPT-3.5 Turbo w obecnym portfolio OpenAI. GPT-4o mini osiągnąć wynik 82% w MMLU, tylko nieznacznie niższy od GPT-4o (89%). Jego główni rywale Gemini 1.5 Flash i Claude 3 Haiku osiągają w nim odpowiednio 79% i 75%. Najnowszy model GPT osiągnął też lepsze wyniki w innych benchmarkach: GPQA, DROP, MGSM, MATH, HumanEval, MMMU i MathVista.

GPT-4o mini będzie kosztował około 0,60 USD na milion tokenów wyjściowych i 0.15 USD na milion tokenów wejściowych. Jest o 60% tańszy w użytkowaniu od modelu GPT-3.5 Turbo, który zastąpi. Cena jest praktycznie taka sama jak Gemini 1.5 Flash i Claude 3 Haiku. Okno kontekstu pozostaje przy 128 tys. tokenów, zaś baza wiedzy ucina się na październiku 2023. GPT-4o mini obsługuje tekst i obraz poprzez API, a w przyszłości zyska też obsługę tekstu, obrazu, wideo i dźwięku jako danych wejściowych. Model jest już dostępny dla deweloperów za pośrednictwem interfejsów API. Konsumenci mogą go zaś używać w ChatGPT w przeglądarce i na smartfonach. W przyszłym tygodniu dostęp do niego uzyskają też klienci Enterprise.

Wraz z wydaniem GPT-4o mini OpenAI wykonał duży krok w uczynieniu zaawansowanej sztucznej inteligencji bardziej przystępną cenowo dla szerszego grona użytkowników. Przy zachowaniu wysokiego poziomu wydajności nowy model LLM odpowiada na rosnące zapotrzebowanie na tanie modele AI, które można integrować z aplikacjami klientów.

Źródło: https://openai.com/index/gpt-4o-mini-advancing-cost-efficient-intelligence/