Obecnie wiele rzeczy, które wcześniej były możliwe do osiągnięcia jedynie za pomocą sensorów, teraz można zastąpić sztuczną inteligencją, która potrafi przeanalizować zebrane dane i uzyskać bardzo dokładne wyniki. Przykładem tego jest wykrywanie gestów i ruchów dłoni. W goglach HoloLens takich sensorów (które między innymi wykrywają głębie) jest kilka. Skutkiem ubocznym tego są niestety spore rozmiary gogli. Choć ich druga generacja jest dużo wygodniejsza, to nadal daleko im choćby do wygody Google Glass.

Google Glass jednak nie zdobyło sporego zainteresowania, głównie przez swoją niską funkcjonalność. W tej kategorii HoloLens bije Glass na głowę, właśnie dzięki obecności szeregu sensorów. Google postanowiło poszukać rozwiązania tego problemu i w tym celu sięgnęło po możliwości, jakie daje sztuczna inteligencja. Pytanie brzmi - jak za pomocą AI sprawić, by Glass potrafiło dokładnie rozpoznawać gesty i ruch dłoni tylko za pośrednictwem obrazu z kamerki? Bez wykorzystania sensorów, których nie uda się zmieścić w tak niewielkim urządzeniu?

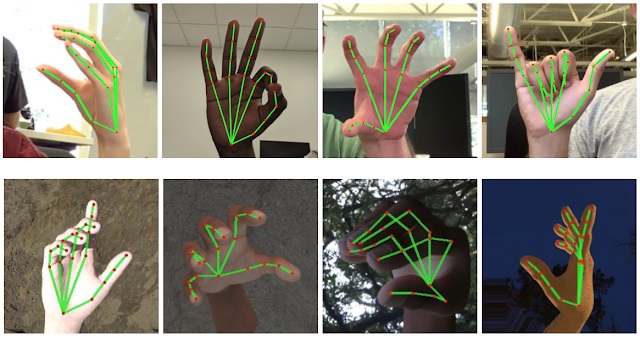

Najwidoczniej udało się to osiągnąć. Główną innowacją w tej nowej technologii jest użycie konwencjonalnego algorytmu do wykrywania dłoni, a następnie zastosowanie modelu opartego na sztucznej inteligencji do przewidywania pozycji palców. Zespół, pracujący nad tą technologią, udostępnił kod jako wieloplatformowy framework o nazwie MediaPiPe.

MediaPipe może wykryć do 21 punktów na dłoni i palcach z dokładnością do 96% i zrobić to wszystko lokalnie, bez wykorzystania chmury. Daje to świetną perspektywę wykorzystania tej technologii nie tylko w kolejnych wersjach Glass, ale również w smartfonach. Może to też wpłynąć na cenę tego typu urządzeń, która znacznie spadnie. W końcu, jeśli coś można zrealizować za pomocą oprogramowania, a nie podzespołów, to takie urządzenie będzie wtedy dużo tańsze w produkcji. Więcej na temat tego projektu można przeczytać na stronie Google.