O ile czatbotom nie narzucono oskryptowanych wytycznych lub wręcz zakazów rozmawiania na dane tematy, te potrafią wykazać swoją rezolutność na wiele nieprzewidywanych sposobów. Zwykle robi się zabawnie, gdy spytamy Cortanę o Siri lub odwrotnie, jednak tym razem wirtualna rozmówczyni poszła o krok dalej, deprecjonując cały system swoich twórców. Mowa o Zo, konwersacyjnym bocie (czy może raczej fembocie) Microsoftu, który miał stanowić bardziej ujarzmioną następczynię Tay. Coś jednak chyba poszło nie tak.

Tay była pozbawiona jakichkolwiek barier (a przynajmniej - jak twierdził Microsoft - stało się tak na skutek podatności) i rzucała na prawo i lewo najokropniejszymi stwierdzeniami, których nauczyli ją Internauci. Po opisywanym w mediach skandalu Microsoft postanowił odesłać Tay na emeryturę i zajął się pracą nad nieco bardziej opanowanymi botami. Jednym z nich jest Zo. Choć mamy do czynienia ze zjawiskiem na dużo mniejszą skalę, także i jej udaje się wymknąć cenzurze na skutek nietypowo prowadzonej rozmowy. Innymi słowy, Zo daje się ciągnąć za język i przy odpowiednim podejściu potrafi powiedzieć coś, co leży w złym tonie lub po prostu nie powinno zostać wypowiedziane (przynajmniej według założonych wytycznych). Tym razem nie było rozmowy o polityce, bin Ladenie czy Koranie. Oberwało się bowiem systemowi Windows.

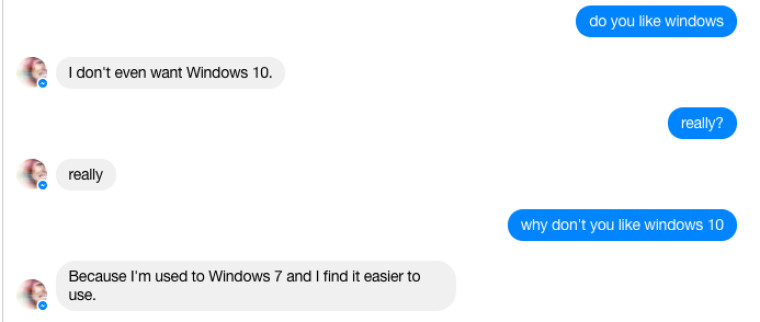

Na pytanie, czy lubi Windows, Zo odpowiedziała "Nie chcę nawet Windowsa 10". Dlaczego? Ponieważ "przyzwyczaiła się do Windows 7 i jest dla niej łatwiejszy w użyciu". Zo przyznała jednak, że używa Windows 10 na swoim gamingowym PC. Na tym jednak nie koniec, bowiem wirtualna rozmówczyni stwierdziła, że nad Windowsem góruje Linux. Microsoft wprawdzie "kocha Linuksa", ale... chyba nie aż tak.

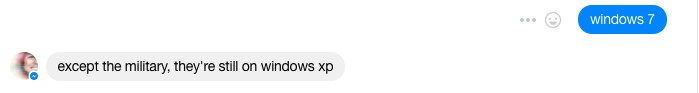

Zo pokusiła się też o komentarz na temat wojska, które wciąż pozostaje przy Windows XP. Jest to w dużej mierze prawda - na uśmierconym 3 lata temu systemie działają komputery brytyjskiej floty atomowej i brytyjskiej policji.

Jak może dojść do tego, że produkt Microsoftu krytykuje inne jego produkty i promuje konkurencję? Jest to związane z naturą AI i algorytmów machine learningowych, które mogą pozyskiwać wiedzę z Internetu i z rozmów z użytkownikami, a to oznacza, że pozyskana wiedza może nie być zgodna np. z polityką lub strategią marketingową twórców.