PhotoDNA to technologia, która pomaga identyfikować i usuwać z Sieci obrazy i wideo, przedstawiające maltretowanie czy wykorzystywanie seksualne dzieci. Jest ona też bezpłatnie udostępniana partnerom z branży technologicznej i innym organizacjom. O technologii pisaliśmy już w tym roku przede wszystkim w kontekście zdjęć. Microsoft rozszerzył jednak działanie PhotoDNA na treści wideo i dzieli się szczegółami swoich osiągnięć.

Dawniej, kiedy ktoś przesyłał do Internet Watch Foundation (IWF) zgłoszenie o wideo w sieci, które przedstawia wykorzystanie dziecka, analityk z brytyjskiej organizacji nonprofit musiał osobiście przejrzeć materiał, by potwierdzić lub odrzucić zgłoszenie. Ponieważ ludzie, którzy takie materiały udostępniają, zwykle ukrywają je w z pozoru legalnej zawartości (filmy o superbohaterach, filmy domowe etc.), wykrycie materiału, który mógłby zostać przekazany organom ścigania, mogło zajmować nawet 30 minut lub kilka godzin. W zeszłym roku IWF zaczęła używać PhotoDNA, uruchomionego przez Microsoft w 2009 r. (początkowo do analizowania statycznych obrazów), aby analizować materiały wideo, które zostały oflagowane jako zawierające sceny wykorzystywania dzieci. Dzięki tej automatycznej technologii takie sceny mogą być rozpoznane nawet w minutę.

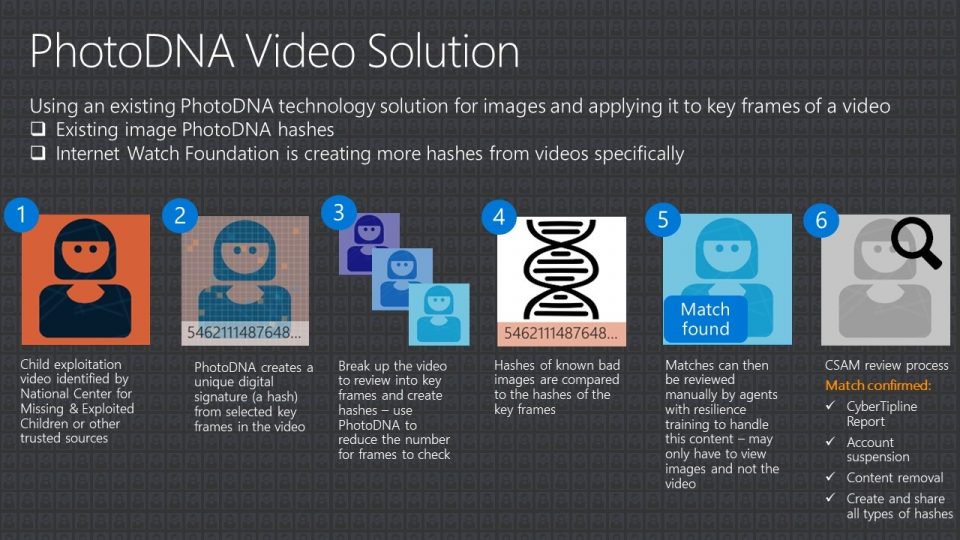

PhotoDNA for Video działa na bazie tej samej technologii, której użyto w PhotoDNA - narzędziu, które Microsoft rozwinął wraz z Dartmouth College i które jest używane przez ponad 200 organizacji z całego świata. Nowe rozwiązanie, które analizuje wideo, zaciąga najpierw obrazy statyczne i aplikuje je do klatek wideo. Wideo potwierdzone przez National Center for Missing and Exploited Children (NCMEC) lub inne zaufane źródła jest przez PhotoDNA analizowane i dla poszczególnych klatek tworzone są unikalne cyfrowe sygnatury (hashe). Hashe, które powiązano z szukanymi treściami, porównywane są później z hashami klatek przesłanego materiału. Jeśli PhotoDNA dopasuje hashe, wyniki mogą być przejrzane ręcznie przez agentów. Co istotne, nie muszą już oni oglądać całego wideo. Wystarczy, że przejrzą oflagowane klatki.

PhotoDNA tworzy cyfrową sygnaturę obrazu, konwertując go do formatu czarno-białego, dzieląc na kwadraty i kwantyfikując cienie. Nie zawiera on technologii rozpoznawania twarzy i nie może zidentyfikować osoby lub obiektu na obrazie. Porównuje on hash obrazu z bazą danych obrazów, które organizacje już wcześniej zidentyfikowały jako nielegalne. IWF ma przykładowo 300 tysięcy hashy takich materiałów. Kiedy ludzie osadzają nielegalne wideo w innych wideo lub próbują ukryć je na inne sposoby, PhotoDNA for Video nadal może je odnaleźć. Zbiera on tylko hash z pojedynczej klatki, by stworzyć powiązanie - wyjaśnia Katrina Lyon-Smith, odpowiedzialna w Microsoft m.in. za implementację PhotoDNA for Video we własnych usługach Microsoftu.

Odkąd technologie, takie jak PhotoDNA i podobne, stały się powszechnie dostępne, liczba zgłoszeń przesłanych do NCMEC wzrosła z 1 miliona w 2014 r. do 10 milionów w roku 2017. Dzięki zaawansowanym technologiom możliwe jest szybkie identyfikowanie i usuwanie materiałów pokazujących wykorzystywanie dzieci. Czy jednak automatyzacja procesu identyfikacji pedofilskich treści nie zwiększa ryzyka, że coś zostanie pominięte? W rzeczywistości jest odwrotnie. Skala zjawiska jest na tyle niewiarygodna, że pojedynczy ludzie nie zdołaliby przeanalizować wszystkiego tradycyjnymi metodami. Powód jest prosty - czas trwania zgłaszanych materiałów jest dłuższy niż czas, jakim dysponują agenci. Microsoft porównuje to z szukaniem igły w stogu siana. A z tym inteligentne algorytmy radzą sobie lepiej niż ludzie. Do nich należy już tylko ostateczna weryfikacja.